Top-KI-Influencer 2025: Verifiziert, respektiert, gefolgt

In Kürze Ein Blick auf zehn Persönlichkeiten, die die Zukunft der künstlichen Intelligenz im Jahr 2025 prägen – von den Laboren, die ihre Kernkonzepte verfeinern, bis hin zu den politischen Entscheidungsträgern, die ihre Leitplanken setzen. Ihre Ideen, ihre Forschung und ihre Führung bewirken echte Veränderungen in der Art und Weise, wie KI weltweit entwickelt, geteilt und genutzt wird.

Künstliche Intelligenz ist im Jahr 2025 mehr als nur ein Hype. Sie wird nun durch bewährte Forschung, eine stärkere Infrastruktur und die Realität der Entwicklung nachhaltiger Produkte vorangetrieben. Auf X (ehemals Twitter) Viele der Personen, die die Diskussion anführen, sind auch federführend in der Technologie. Sie entwerfen, untersuchen und verwalten Systeme, die deren Einsatz in Unternehmen, der Forschung und Open-Source-Projekten prägen.

Dies ist keine Promi-Liste. Jede Person hier hat echten Einfluss, verfügt über fundiertes Fachwissen und hat bereits erfolgreich Diskussionen innerhalb der KI-Community gelenkt. Ihre Ansichten sind wichtig, denn sie stammen aus der Entwicklung, Steuerung und Herausforderung der Systeme, die unsere Zukunft prägen.

Yann LeCun (@ylecun) — Leitender KI-Wissenschaftler bei Meta

Yann LeCun ist nach wie vor eine der einflussreichsten Stimmen in der KI, insbesondere in der Grundlagenforschung. Seine öffentlichen Kommentare widersprechen oft der vorherrschenden Meinung, insbesondere in Debatten über große Sprachmodelle. Er plädiert für Systeme, die mit deutlich weniger Daten lernen und deutlich weniger Energie verbrauchen, und weicht damit von der Denkweise „Größer ist immer besser“ ab.

LeCuns Platz in der Geschichte ist die Erfindung der Convolutional Neural Networks (CNNs), die heute für die Computervision unverzichtbar sind. Heute ist er ein führender Verfechter des selbstüberwachten Lernens und der autonomen KI – Maschinen, die ihr Verständnis durch Beobachtung statt durch endlose Datenaufnahme entwickeln.

Mittlerweile twittert er nur noch selten Originalinhalte, postet aber häufig ausführliche Essays zur KI-Forschung und zum Systemdesign oder verlinkt darauf.

- Kernthemen: Energieeffiziente Architekturen, objektzentriertes Lernen, Weltmodelle;

- Reichweite des Publikums: über 900,000 Follower;

- Bemerkenswerte Dynamik: häufiger fachlicher Austausch mit Forschern an OpenAI und DeepMind;

Seit mehr als dreißig Jahren prägt seine Arbeit die KI-Strategie von Meta. Ihr Ziel sind Systeme, die auf eine Weise beobachten und denken, die dem menschlichen Denken näher kommt, und nicht nur das nächste Wort in einer Sequenz vorhersagen.

Andrej Karpathy (@karpathy) — Gründungsmitglied von OpenAI

Andrej Karpathy verbindet fundiertes technisches Know-how mit der Perspektive eines Menschen, der bedeutende Produkte zum Leben erweckt hat. Er zerlegt komplexe Ideen – vom Modelldesign über Schulungsentscheidungen bis hin zu Implementierungshürden – auf eine Weise, die sowohl bei Forschern als auch bei praktischen Entwicklern Anklang findet.

Sein Feed verbindet technische Erkenntnisse mit Visionen – so schlug er beispielsweise kürzlich vor, dass große Sprachmodelle zu den Bausteinen moderner Software werden.

- Vermächtnis: frühe Durchbrüche im Deep Learning und Computer Vision, Führung der KI bei Tesla ;

- Reichweite: über 1 Million Follower;

- Engagement: häufige Konferenzvorträge und Aufklärung der Öffentlichkeit;

Nach der Rückkehr zu OpenAI Im Jahr 2024 konzentrierte sich Karpathy darauf, Modelle einfacher zu verwalten und zu skalieren, ohne die Kontrolle zu verlieren. Außerdem arbeitete er daran, der Entwickler-Community mehr Ressourcen zur Verfügung zu stellen. In seinen Beiträgen verknüpft er tiefgreifendes technisches Denken mit der täglichen Arbeit der Softwareentwicklung und zeigt Ingenieuren praktische Möglichkeiten auf, Systeme zu entwickeln, die dem realen Einsatz standhalten.

Fei-Fei Li (@drfeifei) — Professor an Stanford

Fei-Fei Li hat sich einen Namen gemacht, indem sie KI an den Bedürfnissen des Menschen ausgerichtet hat. Sie setzt sich für Designs ein, die dem Gesundheitswesen, der Bildung und dem öffentlichen Interesse ebenso dienen wie den Zielen von Unternehmen und Regierungen. Sie leitete die Entwicklung von ImageNet, einem Projekt, das Deep Learning revolutionierte und die heutige KI nachhaltig prägte.

Ihre Beiträge konzentrieren sich auf die menschliche Seite der KI – ethische Implikationen, Auswirkungen auf das Gesundheitswesen und die Bedeutung der Wahrung der Menschenwürde.

- Bekannt für: IMAGEnet , Stanfords Human-Centered AI Institute;

- Publikum: Über 500,000 Follower, die sowohl US-amerikanische als auch internationale politische Entscheidungsträger beraten;

- Aktueller Schwerpunkt: Ethik, Zugänglichkeit und soziale Inklusion in KI-Anwendungen;

Sie bezieht die Perspektiven von Menschen ein, die in der Technologiebranche oft übersehen werden – etwa von medizinischem Personal, Pädagogen und Menschen mit Behinderungen – und behält deren Anliegen im Fokus. Li sieht verantwortungsvolle KI als eine Frage von Empathie, Weitsicht und der Beteiligung von Stimmen weit außerhalb der Vorstandsetagen des Silicon Valley.

Emad Mostaque (@EMostaque) — Gründer von Stability AI

Emad Mostaque ist ein defiführende Persönlichkeit im Bereich der Open-Source-generativen KI. Er setzt sich dafür ein, dass Modelle und Datensätze auch außerhalb der Reichweite großer Unternehmen zugänglich sind, und hat damit eine Welle von Startups dazu veranlasst, Systeme mit offenen Gewichten zu veröffentlichen.

In seinem Feed teilt er anschauliche Neuigkeiten zu generativer Open-Source-KI und lädt die Öffentlichkeit zu Feedback zur Entwicklung ein.

- Meilenstein: Einführung von Stable Diffusion;

- Schwerpunktbereiche: Kostentransparenz, Offenheit der Infrastruktur, Sicherheitsprinzipien für KI;

- Publikum: über 250,000 Follower;

Mostaque analysiert regelmäßig die tatsächlichen Kosten und Einschränkungen bei der Erstellung komplexer Modelle und bietet so einen seltenen Einblick in die Budgets und den technischen Aufwand, der hinter generativen Werkzeugen steckt. Sein Beharren auf Offenheit hat die Erwartungen an die Möglichkeiten von Entwicklern und Forschern, diese zu prüfen und zu kontrollieren, verändert.

Timnit Gebru (@timnitGebru) — Gründer von DAIR-Institut

Timnit Gebrus Forschung zu algorithmischer Verzerrung und Datentransparenz hat die Diskussion über KI-Fairness auf globaler Ebene verändert. Sie untersucht, wer die Macht in der KI-Entwicklung hat und wie diese Macht die Ergebnisse beeinflusst.

Sie nutzt ihre Präsenz, um auf Voreingenommenheitsprobleme aufmerksam zu machen, und verweist dabei häufig auf ihre Forschung oder wichtige politische Entwicklungen zum Thema Fairness in der KI.

- Schlüsselbereiche: systemische Voreingenommenheit in LLMs, gemeinschaftsgeführte Governance, ethische Datenstandards;

- Publikum: über 160,000 Follower; wird in politischen Rahmenwerken weltweit zitiert;

Sie stützt ihre Argumente auf eindeutige Beweise. Ihre Studien zeigen, wie Fehler in Trainingsdaten reale Ungleichheiten in Bezug auf Rasse, Geschlecht und Klasse fortbestehen lassen können. Gesetzgeber und Regulierungsbehörden beziehen sich bei der Gestaltung von Vorschriften mittlerweile auf ihre Forschung, was sie zu einer führenden kritischen Stimme in der Diskussion gemacht hat.

Chris Olah (@ch402) — Mitbegründer von Anthropisch

Chris Olah hat einige der komplexesten Teile neuronaler Netzwerke entmystifiziert. Seine visuellen und narrativen Erklärungen zur Informationsverarbeitung in Modellen sind zu Lehrmaterial an Universitäten und Referenzpunkten für KI-Sicherheitsforscher geworden.

Er veröffentlicht regelmäßig Updates zur Interpretierbarkeit – seine jüngste Arbeit zur Open-Source-Modellschaltungsanalyse erregte in Sicherheitsforschungskreisen Aufmerksamkeit.

- Spezialgebiet: Interpretierbarkeitstools, Visualisierung von Entscheidungspfaden;

- Publikum: über 150,000 Follower;

- Aktuelle Arbeiten: Modellausrichtung, Sicherheitsprotokolle, konstitutionelle KI;

Indem er die inneren Abläufe der KI sichtbar machte, hat Olah die Interpretierbarkeit von einer akademischen Kuriosität zu einer zentralen Voraussetzung für Vertrauen und Sicherheit gemacht. Sein Einfluss prägt die Denkweise von Laboren und politischen Entscheidungsträgern über die Überwachung und Steuerung des Modellverhaltens.

Sara Hooker (@sarahookr) — Direktor bei Cohere für KI

Sara Hooker arbeitet daran, maschinelles Lernen effizienter und zugänglicher zu machen. Sie konzentriert sich auf Forscher in Regionen mit geringeren Ressourcen und möchte so die Beteiligung der Forscher an diesem Forschungsgebiet dezentralisieren.

In ihren Beiträgen rückt die Inklusivität in der KI-Forschung in den Mittelpunkt – kürzlich hat sie auf die Grenzen computergestützter Regulierung aufmerksam gemacht.

- Schwerpunkte: spärliche Modelle, Reproduzierbarkeit, inklusive KI-Forschung;

- Publikum: über 45,000 Follower;

Ihre Arbeit stellt die Annahme in Frage, dass ernsthafte Forschung nur mit riesigen Infrastrukturen möglich sei. Indem sie effiziente Architekturen und globale Zusammenarbeit fördert, verändert Hooker die Erwartungen an Leistung und Beteiligung an der KI.

Ethan Mollick (@emollick) — Professor an Wharton

Ethan Mollick zeigt, wie KI-Tools die Art und Weise verändern, wie Menschen lernen und arbeiten. Seine Experimente mit großen Sprachmodellen im Klassenzimmer und im Geschäftsumfeld liefern konkrete, reproduzierbare Ergebnisse.

Sein Feed bringt KI in reale Unterrichts- und Büroszenarien und untersucht, wie sich Prompt-Design und Arbeitsplatztools weiterentwickeln und das Lernen beeinflussen.

- Schwerpunkte: Angewandte LLMs, Prompt Engineering, KI-gestützte Workflows;

- Publikum: über 280,000 Follower;

Mollick probiert die Tools selbst aus, beobachtet, was passiert, und passt seinen Ansatz kontinuierlich an. Dieser praktische Ansatz bietet Pädagogen und Fachleuten eine Blaupause für die Integration von KI mit minimalem Aufwand.

Dario Amodei (@darioamodei) — CEO von Anthropisch

Dario Amodei leitet eine der am meisten beobachteten KI-Sicherheitsinitiativen. Anthropics Entwicklung von Claude ist Teil einer umfassenderen Strategie, die Skalierung sicherer zu machen, ohne Innovationen zu behindern.

Er postet selten etwas, doch wenn er es tut, sorgen seine Ansichten für Diskussionen. Erst kürzlich kritisierte er eine Darstellung, die seiner Ansicht nach die Sicherheitsmission von Anthropic verzerrt.

- Schwerpunkt: Verfassungsmäßige KI, Systemzuverlässigkeit, Ausrichtung im großen Maßstab;

- Publikum: über 70,000 Follower; Anerkennung bei Anhörungen im Parlament und auf globalen Gipfeltreffen;

Amodeis besonnener Stil und seine Betonung von Kontrollmechanismen haben seine Arbeit zu einem Bezugspunkt für Industrie und Regierung gemacht, wenn es darum geht, Erwartungen an die Modellüberwachung zu formulieren.

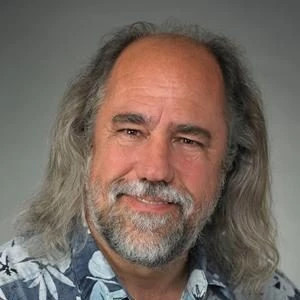

Grady Booch (@Grady_Booch) — Chefwissenschaftler für Softwareentwicklung bei IBM Research

Grady Boochs Karriere konzentriert sich auf die Entwicklung und Verwaltung komplexer Softwaresysteme. Daher sind seine Ansichten zum Aufbau und zur Wartung moderner KI besonders wertvoll. Jahrzehntelange Erfahrung in der Entwicklung langlebiger Systeme ermöglicht es ihm, die Anforderungen nachhaltiger KI-Entwicklung aufzuzeigen.

Seine Stimme verbindet eine tiefe Systemdesignperspektive mit dem KI-Kontext – obwohl Aktualisierungen seltener erfolgen, bringt er architektonische Klarheit in die KI-Debatte.

Booch ist vor allem für die Entwicklung von UML (Unified Modeling Language) bekannt und wendet strenges Architekturdenken auf Fragen der KI-Bereitstellung und -Zuverlässigkeit an.

- Kernthemen: Systemdesign, Haltbarkeit, Ethik im Ingenieurwesen;

- Publikum: Über 160,000 Follower aus der KI- und traditionellen Ingenieurscommunity;

Er warnt davor, dass zu schnelles Vorgehen die bereits geleistete Arbeit untergraben könnte. Seiner Ansicht nach sind dauerhafte Fortschritte das Ergebnis geduldiger Entwicklung, strenger Tests und der Verpflichtung zu soliden Ingenieurpraktiken.

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

Bitget Spot Margin Ankündigung zur Aussetzung von DOG/USDT, ORDER/USDT, BSV/USDT, STETH/USDT Margin Trading Diensten

Weihnachts- und Neujahrskarneval für BGB-Inhaber: Kaufen Sie 1 BGB und gewinnen Sie bis zu 2026 BGB!

Bitget Trading Club Championship (Phase 20) – bis zu 2.400 BGB pro Nutzer plus ein RHEA-Pool und Mystery Boxen

Bitget Spot Margin Ankündigung zur Aussetzung von ICNT/USDT, PROMPT/USDT, CAMP/USDT, FARTCOIN/USDT, PEAQ/USDT Margin Trading Diensten