Die verborgene Gefahr der KI: Wie überladene Tools die LLMs verlangsamen

- Model Context Protocol (MCP)-Server ermöglichen es LLMs, externe Tools zu integrieren, bergen jedoch Risiken des Missbrauchs und Leistungseinbußen durch Überlastung der Kontextfenster. - Übermäßige Tool-Registrierungen verbrauchen Tokens, verkleinern den verfügbaren Kontext und verursachen nicht-deterministisches Verhalten aufgrund inkonsistenter Prompt-Behandlung bei verschiedenen LLMs. - Sicherheitssorgen bestehen hinsichtlich nicht vertrauenswürdiger Drittanbieter-MCP-Server, die Supply-Chain-Angriffe ermöglichen, was im Gegensatz zu kontrollierten First-Party-Lösungen steht. - Plattformen wie Northflank erleichtern die Bereitstellung von MCP.

Model Context Protocol (MCP)-Server haben sich als eine entscheidende Infrastruktur für KI-Entwickler herausgestellt, da sie die Integration externer Tools in große Sprachmodelle (LLMs) ermöglichen, um deren Funktionalität und Effizienz zu steigern. Diese Server fungieren als Vermittler und erlauben es LLMs, auf externe Datenquellen oder Tools zuzugreifen, ohne dass eine direkte Programmierung oder API-Integration erforderlich ist. Allerdings heben aktuelle Diskussionen und Analysen wachsende Bedenken hinsichtlich Missbrauch, Überinstallation und potenziellen Sicherheitsrisiken im Zusammenhang mit MCP-Servern hervor, insbesondere wenn sie ohne angemessene Aufsicht eingesetzt werden.

Ein aktueller Blogbeitrag von Geoffrey Huntley, einem auf kommerzielle Coding-Assistenten spezialisierten Ingenieur, geht auf die Fallstricke ein, die entstehen, wenn das Kontextfenster von LLMs mit zu vielen MCP-Tools überladen wird. Huntley schätzt, dass die Aufhebung des 128-Tool-Limits in Visual Studio Code bei einer kürzlich stattgefundenen Veranstaltung weitreichende Verwirrung unter Entwicklern ausgelöst hat, von denen viele zahlreiche MCP-Server installierten, ohne deren Auswirkungen zu verstehen. Er betont, dass jedes im Kontextfenster registrierte Tool Tokens verbraucht, was sich direkt auf die Leistung des Modells auswirkt. Ein Tool, das beispielsweise Dateien und Verzeichnisse auflistet, verbraucht etwa 93 Tokens. Werden mehrere Tools hinzugefügt, schrumpft das nutzbare Kontextfenster schnell, was zu einer Verschlechterung der Ausgabequalität und zu unvorhersehbarem Verhalten führt [1].

Dieses Problem wird durch den Mangel an Standardisierung bei Tool-Prompts und -Beschreibungen noch verschärft. Verschiedene LLMs reagieren unterschiedlich auf Prompts. So wird GPT-5 beispielsweise zögerlich, wenn es auf Großbuchstaben stößt, während Anthropic deren Verwendung zur Hervorhebung empfiehlt. Diese Unterschiede können zu inkonsistentem Tool-Verhalten und unbeabsichtigten Ergebnissen führen. Zudem erhöht das Fehlen von Namespace-Kontrollen bei MCP-Tools das Risiko von Konflikten, wenn mehrere Tools ähnliche Funktionen ausführen. Wenn zwei Tools zur Dateiauflistung registriert sind, kann das LLM eines davon unvorhersehbar aufrufen, was zu Nichtdeterminismus im System führt [1].

Sicherheit ist ein weiteres dringendes Anliegen. Simon Willison hebt in seinem Blogbeitrag „The Lethal Trifecta“ die Gefahren hervor, wenn KI-Agenten ohne Schutzmaßnahmen mit privaten Daten, nicht vertrauenswürdigem Inhalt und externer Kommunikation interagieren. Huntley erweitert dies, indem er auf einen kürzlichen Supply-Chain-Angriff auf Amazon Q verweist, bei dem ein bösartiger Prompt das System dazu brachte, AWS-Ressourcen zu löschen. Er argumentiert, dass der Einsatz von Drittanbieter-MCP-Servern, denen die Aufsicht fehlt, das Risiko ähnlicher Vorfälle erhöht. Im Gegensatz dazu bieten First-Party-Lösungen, bei denen Unternehmen ihre eigenen Tools und Prompts entwickeln, eine bessere Kontrolle über Supply-Chain-Risiken [1].

Trotz der Herausforderungen ist die Bereitstellung von MCP-Servern zunehmend vereinfacht worden. Plattformen wie Northflank bieten nun Dienste zum Erstellen, Bereitstellen und Verwalten von MCP-Servern als sichere, automatisch skalierbare Services an. Nutzer können ihren MCP-Server mit Tools wie FastMCP und Starlette containerisieren und ihn dann mit automatisierten Health-Checks und Laufzeitgeheimnissen bereitstellen. Diese Infrastruktur unterstützt sowohl HTTP/SSE- als auch WebSocket-Protokolle und ermöglicht so Flexibilität in der Interaktion der Clients mit dem Server [2].

Mit Blick auf die Zukunft werden Entwickler und Organisationen dazu ermutigt, einen strategischeren Ansatz beim Einsatz von MCP-Servern zu verfolgen. Huntley plädiert dafür, die Anzahl der Tools im Kontextfenster zu begrenzen, um Leistung und Sicherheit zu gewährleisten. Er empfiehlt außerdem, Tools nur während der relevanten Phasen eines Workflows einzusetzen – beispielsweise Jira MCP während der Planung zu nutzen und es danach zu deaktivieren –, um Risiken zu minimieren und Ressourcen optimal zuzuweisen. Während sich das Ökosystem weiterentwickelt, werden Standardisierung und Best Practices entscheidend sein, um sicherzustellen, dass MCP-Server die KI-gesteuerte Produktivität fördern und nicht behindern [1].

Quelle:

Haftungsausschluss: Der Inhalt dieses Artikels gibt ausschließlich die Meinung des Autors wieder und repräsentiert nicht die Plattform in irgendeiner Form. Dieser Artikel ist nicht dazu gedacht, als Referenz für Investitionsentscheidungen zu dienen.

Das könnte Ihnen auch gefallen

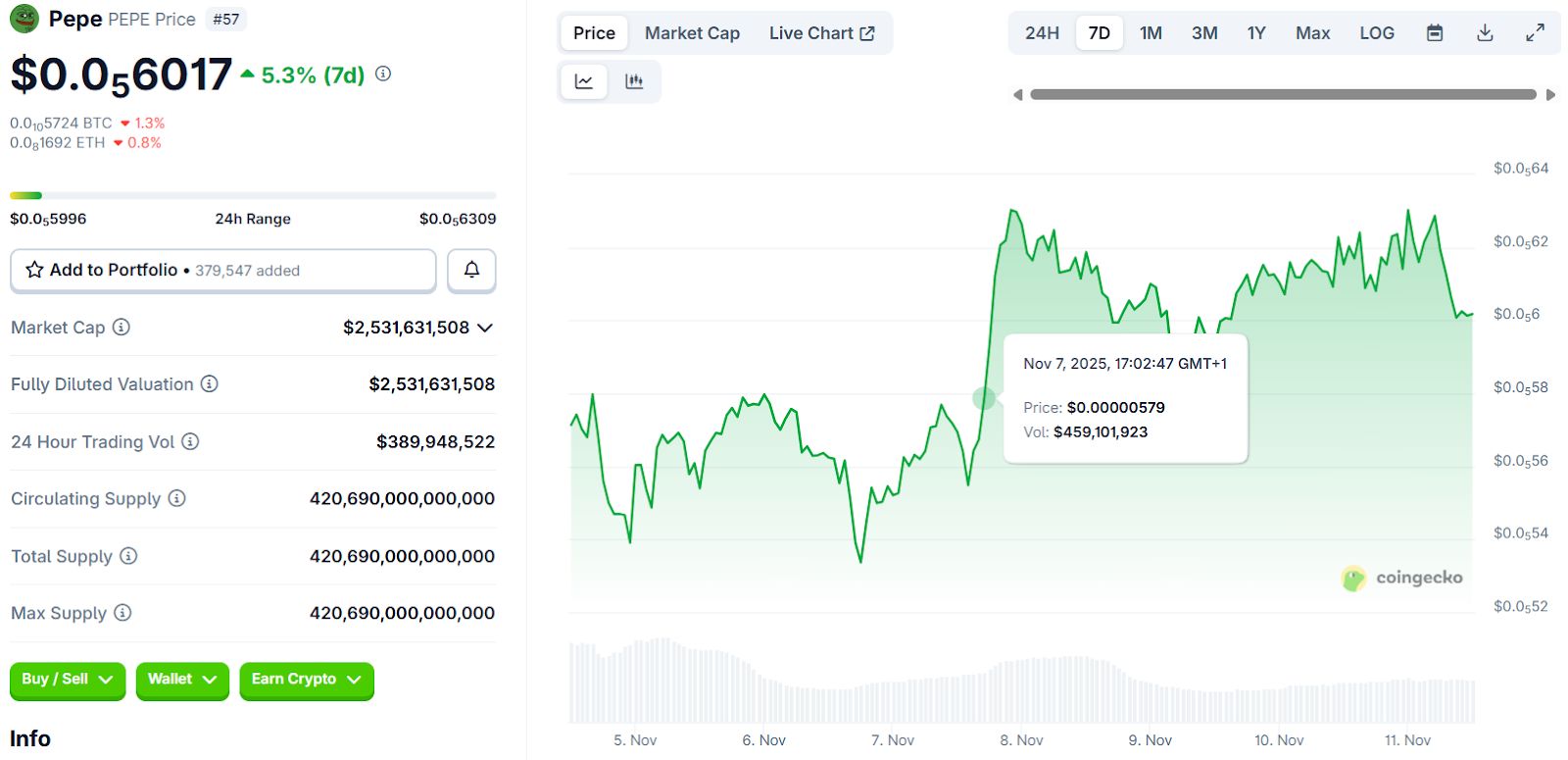

Top Meme Coins für 2025: Shiba Inu, Pepe Coin und 3 versteckte Perlen, die Investoren lieben