Un criminel a utilisé un modèle d’IA pour voler des informations médicales, des données financières et des identifiants gouvernementaux, menaçant de divulguer les données à moins d’être payé plus de 500 000 $.

Anthropic déclare qu’un cybercriminel a utilisé son modèle d’intelligence artificielle (IA) pour voler des informations personnelles sensibles et exiger d’importantes rançons afin de ne pas les divulguer.

Les membres de l’équipe de renseignement sur les menaces d’Anthropic, Alex Moix, Ken Lebedev et Jacob Klein, indiquent dans un nouveau rapport qu’un cybercriminel a détourné le chatbot Claude de la société d’IA pour faciliter le vol de données et les demandes de rançon.

« Nous avons récemment perturbé un cybercriminel sophistiqué qui utilisait Claude Code pour commettre un vol et une extorsion de données personnelles à grande échelle. L’acteur a ciblé au moins 17 organisations distinctes… »

L’acteur a utilisé l’IA à un degré que nous pensons sans précédent. Claude Code a été utilisé pour automatiser la reconnaissance, récolter les identifiants des victimes et pénétrer les réseaux. Claude a été autorisé à prendre des décisions tactiques et stratégiques, telles que décider quelles données exfiltrer et comment élaborer des demandes d’extorsion psychologiquement ciblées. Claude a analysé les données financières exfiltrées pour déterminer les montants de rançon appropriés et a généré des notes de rançon visuellement alarmantes qui étaient affichées sur les machines des victimes. »

Anthropic indique que le cybercriminel a orchestré « une campagne d’attaques systématiques axée sur le vol de données exhaustif et l’extorsion » en utilisant le modèle d’IA.

« L’acteur a fourni à Claude Code ses TTP (Tactiques, Techniques et Procédures) opérationnels préférés dans son fichier CLAUDE.md, qui sert de guide pour que Claude Code réponde aux instructions de la manière souhaitée par l’utilisateur… »

L’approche systématique de l’acteur a entraîné la compromission de dossiers personnels, y compris des données de santé, des informations financières, des identifiants gouvernementaux et d’autres informations sensibles, avec des demandes de rançon directes dépassant parfois 500 000 $.

L’entreprise précise également que l’utilisation de ses modèles d’IA à des fins illicites se produit malgré ses efforts pour les limiter.

« Nous avons développé des mesures sophistiquées de sécurité et de sûreté pour empêcher l’utilisation abusive de nos modèles d’IA. Bien que ces mesures soient généralement efficaces, les cybercriminels et autres acteurs malveillants tentent continuellement de les contourner. »

Image générée : Midjourney

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

Tether vise un accord de robotique de 1 milliard d’euros — Un grand pas au-delà des stablecoins

Les plus grandes baleines Hyperliquid vendent à découvert au milieu d'une forte volatilité du marché

D'importantes positions courtes prises par les principales baleines de Hyperliquid, combinées à une peur et une panique croissantes sur les réseaux sociaux, suggèrent que le marché crypto pourrait approcher d'un point de basculement.

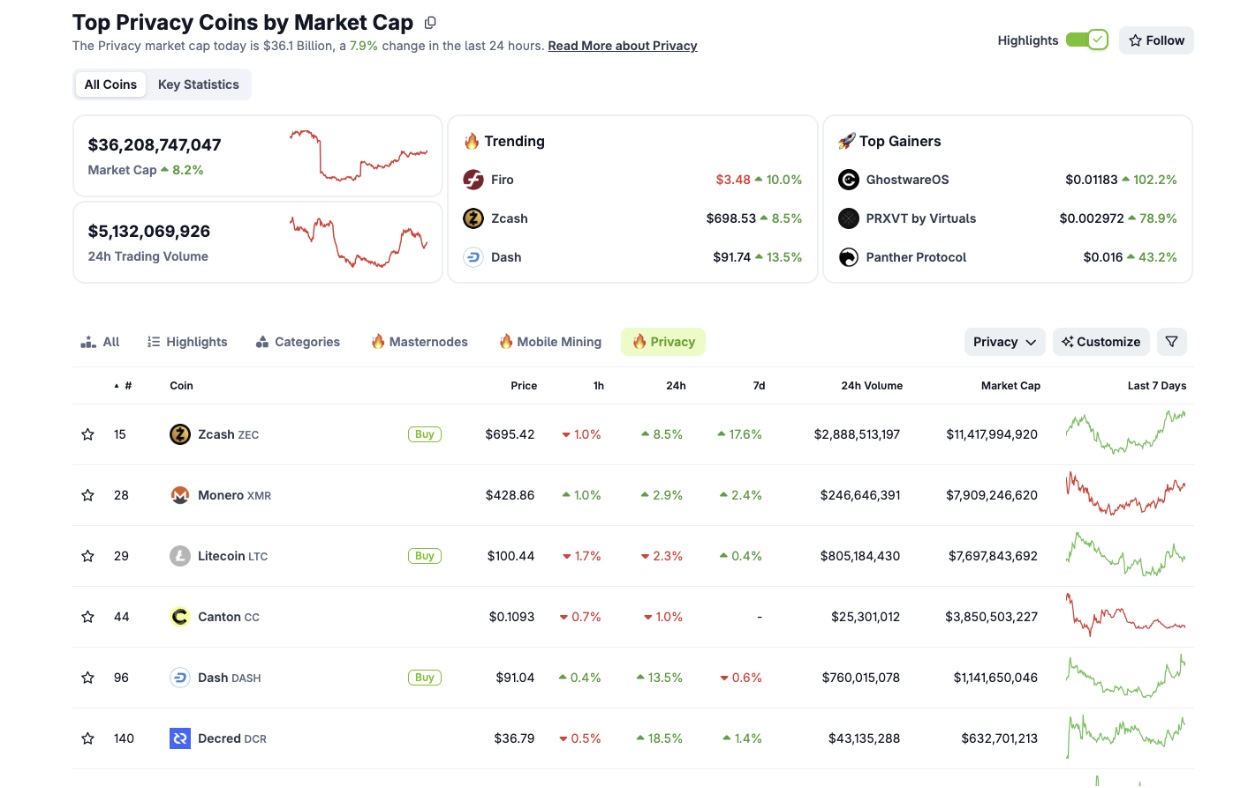

Les crypto-monnaies axées sur la confidentialité s'envolent alors que les tensions politiques montent avant le vote du Congrès

Les privacy coins ont fortement progressé alors que les marchés se préparent à un vote crucial du Congrès américain qui pourrait obliger le président Trump à publier des dossiers liés à Epstein.