Mistral Meluncurkan Mistral 3: Model Open-Source Generasi Berikutnya untuk AI Enterprise dan Edge

Singkatnya Mistral baru saja merilis Mistral 3, keluarga baru yang terdiri dari 10 model bobot terbuka, yang dirancang untuk berjalan di semua perangkat, mulai dari cloud konsumen hingga laptop, drone, dan robot.

Startup AI mistral Telah meluncurkan Mistral 3, generasi terbaru modelnya, yang menampilkan tiga model padat yang ringkas dan berkinerja tinggi dengan parameter 14B, 8B, dan 3B, bersama Mistral Large 3, model tercanggihnya hingga saat ini—sebuah sistem dengan campuran pakar yang terlatih dengan 41B parameter aktif dan 675B parameter total. Semua model tersedia di bawah lisensi Apache 2.0, yang memberikan akses sumber terbuka kepada pengembang dalam berbagai format terkompresi untuk mendukung aplikasi AI terdistribusi.

Model Ministral dirancang untuk efisiensi kinerja-biaya yang tinggi, sementara Mistral Large 3 memposisikan dirinya di antara model-model sumber terbuka terkemuka yang telah disempurnakan sesuai instruksi. Dilatih dari awal dengan 3,000 GPU NVIDIA H200, Mistral Large 3 menandai rilis pertama perusahaan yang menggunakan gabungan para ahli sejak seri Mixtral dan merupakan kemajuan signifikan dalam pra-pelatihan. Setelah pasca-pelatihan, Mistral Large 3 menyamai model-model bobot terbuka terbaik yang telah disempurnakan sesuai instruksi pada perintah umum dan menunjukkan pemahaman gambar tingkat lanjut serta kemampuan percakapan multibahasa yang superior.

Mistral Large 3 memulai debutnya di peringkat ke-2 dalam kategori model non-penalaran OSS dan peringkat ke-6 secara keseluruhan di papan peringkat LMArena. Versi dasar dan versi yang disesuaikan dengan instruksi dirilis di bawah Apache 2.0, menawarkan platform yang tangguh untuk kustomisasi perusahaan dan pengembang, dengan versi penalaran yang direncanakan untuk rilis mendatang.

Mistral Bermitra dengan NVIDIA, vLLM, dan Red Hat untuk Meningkatkan Aksesibilitas dan Performa Mistral 3

Mistral Large 3 telah dibuat sangat mudah diakses oleh komunitas sumber terbuka melalui kolaborasi dengan vLLM dan Red Hat. Sebuah checkpoint dalam format NVFP4, yang dioptimalkan dengan llm-compressor, memungkinkan eksekusi yang efisien pada sistem Blackwell NVL72 atau satu node 8×A100 atau 8×H100 menggunakan vLLM.

Pengembangan model AI sumber terbuka yang canggih bergantung pada optimasi perangkat keras-perangkat lunak yang ekstensif, yang dicapai melalui kemitraan dengan NVIDIA. Semua model Mistral 3, termasuk Large 3 dan Ministral 3, dilatih pada GPU NVIDIA Hopper, yang memanfaatkan memori HBM3e bandwidth tinggi untuk beban kerja skala besar. Pendekatan desain bersama NVIDIA mengintegrasikan perangkat keras, perangkat lunak, dan model untuk memungkinkan inferensi yang efisien menggunakan TensorRT-LLM dan SGLang di seluruh keluarga Mistral 3, yang mendukung eksekusi presisi rendah.

Untuk arsitektur Large 3 yang jarang menggunakan pakar, NVIDIA mengimplementasikan kernel Blackwell Attention dan MoE, menambahkan layanan terdisagregasi prefill/decode, dan berkolaborasi dalam decoding spekulatif, yang memungkinkan pengembang menangani beban kerja konteks panjang dan throughput tinggi pada sistem GB200 NVL72 dan seterusnya. Model Ministral juga dioptimalkan untuk penerapan pada DGX Spark, PC dan laptop RTX, serta perangkat Jetson, memberikan pengalaman performa tinggi yang konsisten dari pusat data hingga aplikasi edge. Mistral mengucapkan terima kasih kepada vLLM, Red Hat, dan NVIDIA atas dukungan dan kolaborasi mereka.

Ministral 3: Performa AI Canggih untuk Penerapan Edge dan Lokal

Seri Ministral 3 dirancang untuk penerapan lokal dan edge, ditawarkan dalam tiga ukuran—parameter 3B, 8B, dan 14B. Setiap ukuran tersedia dalam varian dasar, instruksi, dan penalaran, semuanya dilengkapi dengan kemampuan pemahaman gambar dan dirilis di bawah lisensi Apache 2.0. Dikombinasikan dengan kemampuan multimodal dan multibahasa asli, keluarga Ministral 3 menyediakan solusi serbaguna untuk aplikasi perusahaan maupun pengembang.

Seri ini memberikan rasio biaya-kinerja yang luar biasa di antara model-model sumber terbuka, dengan varian instruksi yang menyamai atau bahkan melampaui model yang sebanding sekaligus menghasilkan token yang jauh lebih sedikit. Untuk skenario di mana akurasi sangat penting, varian penalaran dapat melakukan komputasi yang diperluas untuk mencapai akurasi terdepan dalam kelas bobotnya, misalnya 85% pada AIME '25 dengan model 14B.

Mistral 3 saat ini dapat diakses melalui Mistral AI Studio, Amazon Bedrock, Azure Foundry, Hugging Face (Large 3 & Ministral), Modal, IBM WatsonX, OpenRouter, Fireworks, Unsloth AI, dan Together AI, dengan ketersediaan pada NVIDIA NIM dan AWS SageMaker segera hadir.

mistral tetap menjadi kontributor utama bagi ekosistem model AI dan inisiatif sumber terbuka Eropa, meskipun model unggulan terbarunya masih tertinggal dari para pesaing utama di industri dalam hal performa, kecepatan, dan biaya. Varian Ministral yang lebih kecil mungkin menawarkan alternatif yang lebih praktis, menyediakan opsi fleksibel untuk beragam kasus penggunaan dan penerapan di berbagai perangkat.

Disclaimer: Konten pada artikel ini hanya merefleksikan opini penulis dan tidak mewakili platform ini dengan kapasitas apa pun. Artikel ini tidak dimaksudkan sebagai referensi untuk membuat keputusan investasi.

Kamu mungkin juga menyukai

5 Fakta Kunci dari Lonjakan Bitcoin yang Diklaim Fake Breakout

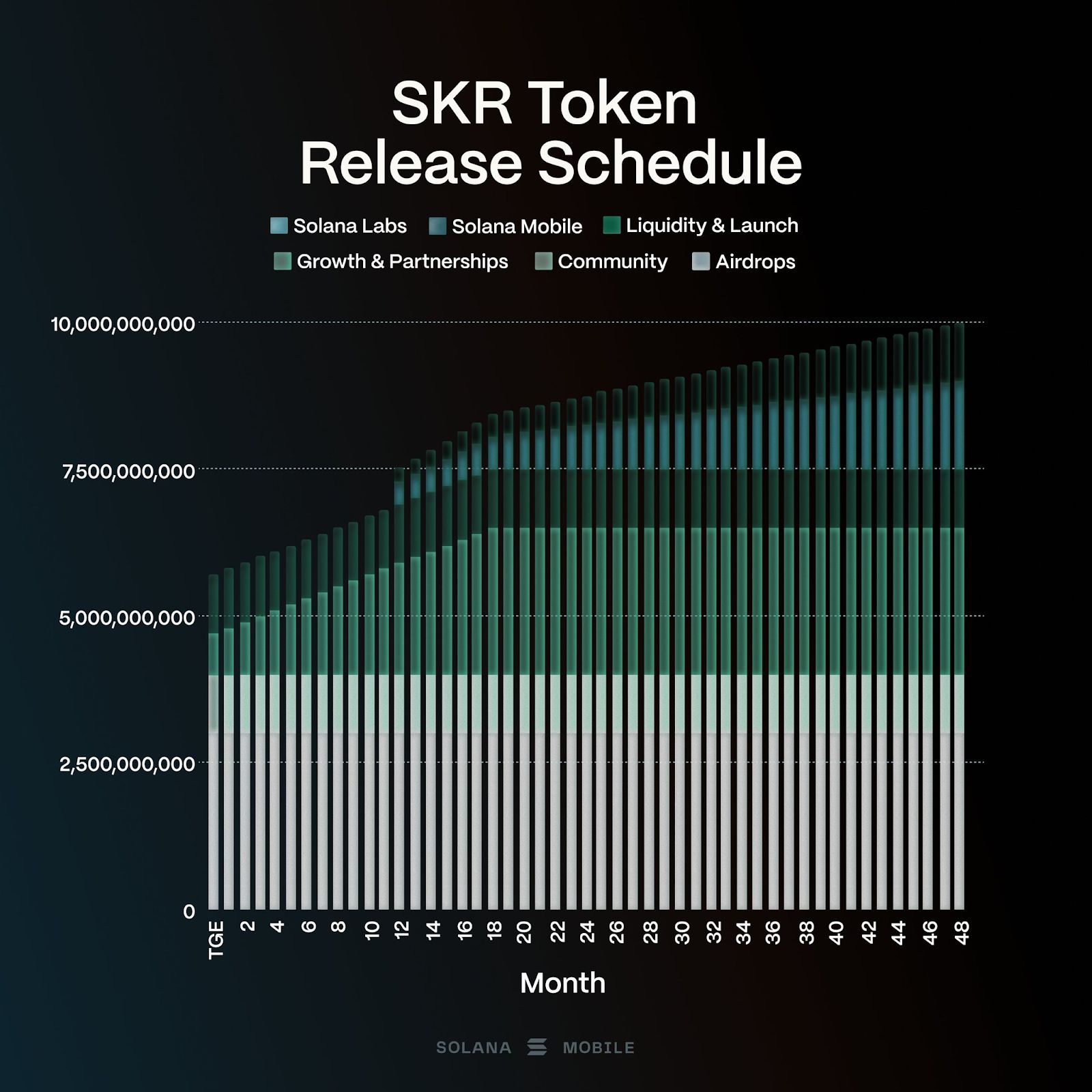

Solana Mobile akan meluncurkan token ‘SKR’ pada Januari 2026; 30% Pasokan Airdrop ke Pengguna Seeker

CZ Mendukung Predict.fun Saat Pasar Prediksi Rantai BNB Menjadi Arus Utama

SEC Memanggil Aturan 18f-4 untuk Memblokir 3x Proposal ETF Solana dan XRP