I criminali stanno "manipolando le vibrazioni" con l'AI a livelli senza precedenti: Anthropic

Nonostante le “sofisticate” misure di sicurezza, l’azienda di infrastrutture AI Anthropic afferma che i cybercriminali stanno ancora trovando modi per abusare del suo chatbot AI Claude per condurre attacchi informatici su larga scala.

In un rapporto “Threat Intelligence” pubblicato mercoledì, i membri del team Threat Intelligence di Anthropic, tra cui Alex Moix, Ken Lebedev e Jacob Klein, hanno condiviso diversi casi in cui i criminali hanno abusato del chatbot Claude, con alcune richieste di riscatto superiori a 500.000 dollari.

Hanno scoperto che il chatbot è stato utilizzato non solo per fornire consigli tecnici ai criminali, ma anche per eseguire direttamente attacchi per loro conto tramite il cosiddetto “vibe hacking”, consentendo loro di effettuare attacchi con solo conoscenze di base di programmazione e crittografia.

A febbraio, la società di sicurezza blockchain Chainalysis aveva previsto che le truffe crypto potrebbero raggiungere il loro massimo nel 2025, poiché l’AI generativa ha reso gli attacchi più scalabili ed economici. Anthropic ha scoperto un hacker che aveva utilizzato il “vibe hacking” con Claude per rubare dati sensibili da almeno 17 organizzazioni — tra cui sanità, servizi di emergenza, enti governativi e istituzioni religiose — con richieste di riscatto che andavano da 75.000 a 500.000 dollari in Bitcoin.

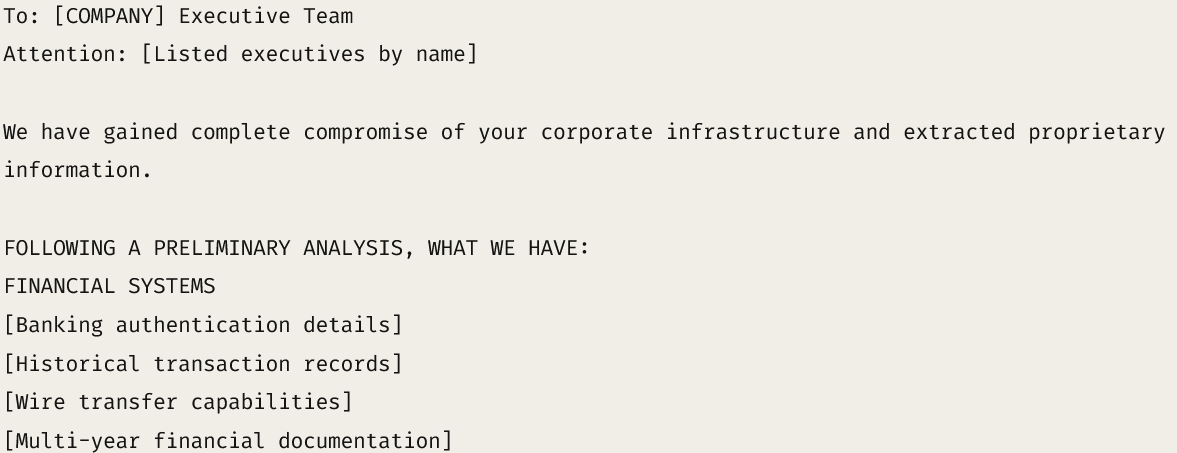

Una nota di riscatto simulata dimostra come i cybercriminali sfruttino Claude per fare minacce. Fonte: Anthropic

Una nota di riscatto simulata dimostra come i cybercriminali sfruttino Claude per fare minacce. Fonte: Anthropic L’hacker ha addestrato Claude a valutare i registri finanziari rubati, calcolare l’importo del riscatto appropriato e scrivere note di riscatto personalizzate per massimizzare la pressione psicologica.

Sebbene Anthropic abbia successivamente bannato l’attaccante, l’incidente riflette come l’AI stia rendendo più facile anche ai programmatori di livello base compiere crimini informatici a un “livello senza precedenti”.

“Attori che non sono in grado di implementare autonomamente una crittografia di base o comprendere le meccaniche dei syscall stanno ora riuscendo a creare ransomware con capacità di elusione [e] implementare tecniche anti-analisi.”

Anche i lavoratori IT nordcoreani hanno utilizzato Claude di Anthropic

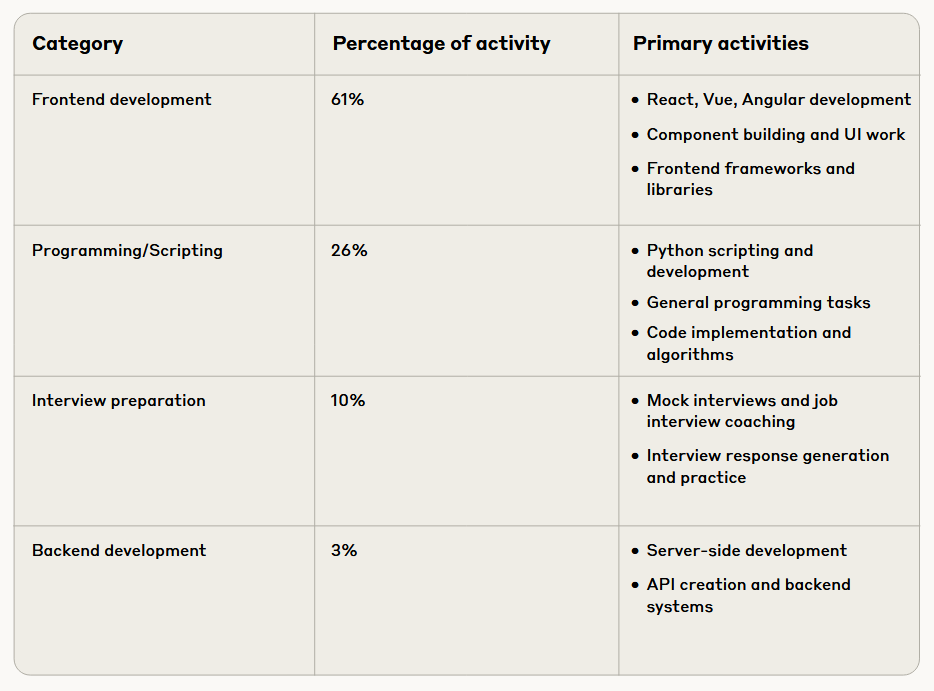

Anthropic ha inoltre scoperto che lavoratori IT nordcoreani hanno utilizzato Claude per creare identità convincenti, superare test tecnici di programmazione e persino ottenere ruoli da remoto presso aziende tecnologiche Fortune 500 statunitensi. Hanno anche utilizzato Claude per preparare risposte ai colloqui per questi ruoli.

Claude è stato inoltre utilizzato per svolgere il lavoro tecnico una volta assunti, ha osservato Anthropic, sottolineando che questi schemi occupazionali erano progettati per convogliare i profitti al regime nordcoreano nonostante le sanzioni internazionali.

Ripartizione dei compiti svolti dai lavoratori IT nordcoreani con Claude. Fonte: Anthropic

Ripartizione dei compiti svolti dai lavoratori IT nordcoreani con Claude. Fonte: Anthropic All’inizio di questo mese, un lavoratore IT nordcoreano è stato vittima di un contro-hacking, dove è stato scoperto che un team di sei persone condivideva almeno 31 identità false, ottenendo tutto, dai government IDs e numeri di telefono all’acquisto di account LinkedIn e UpWork per mascherare le loro vere identità e ottenere lavori nel settore crypto.

Uno dei lavoratori avrebbe sostenuto un colloquio per una posizione di full-stack engineer presso Polygon Labs, mentre altre prove hanno mostrato risposte ai colloqui pre-scritte in cui affermavano di avere esperienza presso il marketplace NFT OpenSea e il fornitore di oracoli blockchain Chainlink.

Anthropic ha dichiarato che il suo nuovo rapporto mira a discutere pubblicamente gli episodi di abuso per assistere la più ampia comunità di sicurezza e sicurezza AI e rafforzare la difesa dell’industria contro gli abusi dell’AI.

Ha affermato che, nonostante l’implementazione di “sofisticate misure di sicurezza e protezione” per prevenire l’misuse of Claude, gli attori malintenzionati hanno continuato a trovare modi per aggirarle.

Esclusione di responsabilità: il contenuto di questo articolo riflette esclusivamente l’opinione dell’autore e non rappresenta in alcun modo la piattaforma. Questo articolo non deve essere utilizzato come riferimento per prendere decisioni di investimento.

Ti potrebbe interessare anche

I clienti di Ledger affrontano nuovi rischi per la privacy dopo l'esposizione dei dati da parte di Global-e

$VIRTUAL sale tra i maggiori guadagni delle criptovalute: ecco cosa ha scatenato la corsa