Resumo de final de ano de 2025 por Tian Yuandong (Parte 1)

Reportagem da Nova Inteligência

Reportagem da Nova Inteligência

【Introdução da Nova Inteligência】De ser chamado para "apagar incêndio" no Llama 4 e acabar sendo demitido, até agora embarcar em um novo empreendimento, o especialista em IA Tian Yuandong relembra alguns momentos importantes de 2025.

Estive muito ocupado recentemente, então só consegui escrever o resumo de fim de ano após o dia 1º de janeiro. De qualquer forma, começar já é um bom sinal.

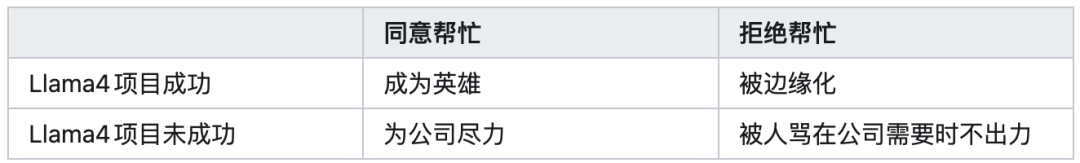

No final de janeiro de 2025, quando fui solicitado a me juntar aoLlama4 para "apagar incêndio", como alguém que sempre trabalhou com aprendizado por reforço, desenhei previamente uma matriz de recompensas 2x2 para calcular quatro possibilidades (embora, naquela época, devido à enorme pressão de cima, discordar era quase impossível):

Na época, pensei que se fôssemos ajudar, mesmo que o projeto não tivesse sucesso, pelo menos teríamos feito o nosso melhor e não teríamos arrependimentos. No entanto, infelizmente, o que aconteceu foi a quinta possibilidade, que não estava nos meus cálculos, o que me deu uma compreensão mais profunda da complexidade da sociedade.

Apesar disso, durante esses meses de esforço, ainda fizemos algumas explorações em questões centrais do treinamento por reforço, como estabilidade do treinamento, interação entre treinamento e inferência, design da arquitetura do modelo, interação entre pré-treinamento/treinamento intermediário, algoritmos de cadeia de raciocínio longa, formas de geração de dados, design de frameworks de pós-treinamento etc.

Essa experiência em si foi muito importante e também trouxe mudanças significativas à minha linha de pesquisa.

Na verdade, eu já pensava que, após mais de dez anos na empresa, um dia teria que sair, não dava para passar a vida inteira lá, mas, por várias razões econômicas e familiares, continuei ficando.

No último ano ou dois, a forma como falo e ajo tem sido com uma mentalidade de "que a empresa me demita logo", o que me deixou mais relaxado.

No final de 2023, quando tirei minhas primeiras férias longas, quase saí, mas, no fim, não assinei e decidi ficar, então realmente não é fácil tomar a decisão de sair. Agora,Meta fez isso por mim, o que foi bom.

Esses altos e baixos do ano também forneceram muitos novos materiais para meus próximos romances.

Como dizem: "Carreira frustrada favorece poetas; a adversidade torna a escrita melhor". Se a vida for muito monótona, talvez não haja tanta graça. Lembro que, no início de 2021, por escrever algumas reflexões sobre "por que nenhum artigo foi aceito" no resumo anual, ganhei o Meet Most, sentindo repentinamente que tinha falhado.

Mas, pensando bem, em vez de reclamar da injustiça do mundo, era melhor fingir que tinha acabado de ser promovido. Meio ano depois, de fato, fui promovido, e aquele trabalho do início de 2021, que ninguém notou na época, acabou recebendo menção honrosa noICML Best paper honorable mention em julho de 2021, tornando-se um artigo relativamente conhecido em aprendizado de representação.

Por um tempo após 22 de outubro, praticamente todos os meus canais de comunicação estavam sobrecarregados, com inúmeras mensagens, e-mails e convites para reuniões remotas ou encontros todos os dias, realmente não consegui dar conta.

Só algumas semanas depois tudo voltou ao normal. Nestes dois meses, agradeço muito o cuidado e entusiasmo de todos. Se naquela época não respondi alguma mensagem a tempo, peço desculpas.

Apesar de ter recebido muitas ofertas no fim, inclusive de empresas conhecidas que vocês possam imaginar, decidi aproveitar que ainda sou jovem para ser cofundador de uma nova startup. Os detalhes, por enquanto, não serão divulgados, vou trabalhar quieto por um tempo.

Os principais focos de 2025 são a inferência de grandes modelos e a abertura da "caixa-preta" dos modelos.

Desde que tornamos público, no final de 2024, nosso trabalho sobre inferência em espaço latente contínuo (coconut, COLM’25), em 2025 houve uma onda de pesquisas nessa direção. Todos exploram como usar essa ideia no aprendizado por reforço e no pré-treinamento, como aumentar a eficiência de treinamento e computação etc.

Embora nosso grupo tenha sido logo convocado para trabalhar no llama e não tenha conseguido aprofundar tanto, isso me deixou muito satisfeito.

Mesmo assim, publicamos, no primeiro semestre, uma análise teórica (Reasoning by Superposition, NeurIPS‘25), mostrando onde a inferência em espaço latente contínuo tem vantagens, o que atraiu bastante atenção.

Outra linha é como aumentar a eficiência de inferência dos grandes modelos. Nosso trabalhoToken Assorted (ICLR’25) primeiro aprende tokens discretos do espaço latente via VQVAE e depois mistura esses tokens discretos com tokens de texto para pós-treinamento, reduzindo o custo de inferência e aumentando o desempenho.

NossoDeepConf detecta o nível de confiança de cada token gerado para decidir se um caminho de raciocínio deve ser encerrado antecipadamente. Assim, o número de tokens usados diminui bastante, mas o desempenho, especialmente em cenários de majority vote, é ainda melhor.

ThreadWeaver cria cadeias de raciocínio paralelas e faz pós-treinamento nelas para acelerar a inferência. Também treinamos modelos de raciocínio com RL em dLLM (Sandwiched Policy Gradient), além de tentativas de ensinar raciocínio em modelos pequenos (MobileLLM-R1).

Na área de interpretabilidade, venho acompanhando a linha doGrokking (iluminação súbita) há cerca de dois anos. Antes, ao analisar aprendizado de representação, embora fosse possível analisar a dinâmica do aprendizado e ver as razões do colapso das representações, o tipo de representação aprendido, sua relação com a estrutura dos dados e capacidade de generalização ainda eram um mistério. Ao analisar o fenômeno de emergência de características do Grokking, a transição de memória para generalização, conseguimos desvendar esse mistério.

No início, era realmente muito difícil e sem direção. Em 2024, fizemos oCOGS (NeurIPS‘25, vejaAquele que busca o Dao, não se importa com o frio ou o calor (10)), mas foi possível analisar apenas casos especiais, então eu não fiquei muito satisfeito.

Após mais de um ano de incertezas e muita interação com o GPT5, nosso artigo recenteProvable Scaling Laws trouxe avanços significativos, permitindo analisar aspectos que as estruturas lineares (NTK) não viam e explicar a dinâmica do treinamento responsável pela emergência das características. Embora os exemplos analisados ainda sejam especiais, pelo menos abriu-se uma nova janela. Para explicações detalhadas, vejaas ideias de Tian Yuandong.

Gosto muito do artigo de final de anoThe path not taken, que dá uma resposta inicial, no nível dos pesos, para o motivo de RL eSFT se comportarem de forma tão diferente.

O SFT causa overfitting eesquecimento catastrófico, cuja causa superficial é que os dados de treinamento não são on-policy, mas a raiz do problema é que os principais componentes dos pesos são drasticamente modificados por dados externos, tornando a base do modelo instável e causando uma queda acentuada no desempenho.

Já no RL, como o treinamento é feito com dados on-policy, o principal componente dos pesos permanece o mesmo e apenas componentes secundários mudam, evitando assim o problema do esquecimento catastrófico. Os pesos alterados também têm uma distribuição mais esparsa (especialmente sob quantização bf16).

Muitas pessoas acham que interpretabilidade, ou "como a IA funciona tão bem", não é importante, mas eu penso que é. Considere dois cenários futuros:

Cenário 1: Se apenas com Scaling alcançarmos AGI ou até ASI, todo o valor do trabalho humano se reduz a zero, e a IA, como uma enorme caixa-preta, resolve todos os nossos problemas. Então, garantir que a IA, como superinteligência, sempre aja para o bem, sem enganar ou agir de forma maliciosa e oculta, torna-se uma prioridade. Resolver isso exige interpretabilidade.

Cenário 2: Se a abordagem de Scaling falhar no final, e a humanidade não conseguir atender à demanda exponencial por recursos, terá que buscar outras soluções. Nesse caso, será necessário pensar por que o modelo é eficaz e o que pode fazê-lo falhar. Nessa cadeia de pensamento, precisaremos pesquisar, e a interpretabilidade será outro caminho possível.

Em ambos os cenários, a interpretabilidade será fundamental. Mesmo que a IA venha a ser um deus onisciente e benevolente, por natureza, os humanos ainda vão querer entender por que a IA faz tão bem.

Afinal, "caixa-preta" significa o surgimento de uma cadeia de suspeitas. Com a explosão da tecnologia dos grandes modelos, atingindo ou superando o nível médio humano, a regra da "Floresta Sombria" de Três Corpos pode se manifestar de outra forma.

Atualmente, abrir a caixa-preta de modelos bem treinados para encontrar circuitos ainda está em estágio inicial.

A verdadeira dificuldade da interpretabilidade está em, a partir dos princípios primeiros — arquitetura do modelo, descida de gradiente e estrutura inerente dos dados —, explicar por que o modelo converge para essas características e circuitos desacoplados, esparsos, de baixa ordem, modulares e combináveis, por que existem tantas explicações diferentes, como essas estruturas emergentes se relacionam com os hiperparâmetros do modelo, etc.

Quando conseguirmos deduzir, diretamente das equações de descida de gradiente, a inevitabilidade da emergência de características em grandes modelos, a interpretabilidade realmente passará da coleta "biológica" de evidências para a dedução "física" de princípios, orientando a prática e abrindo caminho para a próxima geração de modelos de IA.

Comparando com a física de quatro séculos atrás, hoje temos muitos "Tycho Brahe da IA" (coletando dados), alguns "Kepler da IA" (propondo hipóteses), mas ainda não temos um "Newton da IA" (descobrindo princípios).

Quando esse dia chegar, acredito que o mundo será transformado.

Aviso Legal: o conteúdo deste artigo reflete exclusivamente a opinião do autor e não representa a plataforma. Este artigo não deve servir como referência para a tomada de decisões de investimento.

Talvez também goste

Melhores taxas de CD para 6 de janeiro de 2026: Garanta um rendimento anual de até 4,1% agora

Vitalik direciona o endgame do Ethereum para uma soberania resiliente

Mercado de Criptomoedas Hoje: Bitcoin próximo de US$94 mil, Ethereum estável enquanto XRP e SUI avançam