May-akda: merakiki

Pagsasalin: Deep Tide TechFlow

Sa loob ng mga dekada, napakakitid ng saklaw ng aplikasyon ng teknolohiya ng robotika, na pangunahing nakatuon sa pagsasagawa ng mga paulit-ulit na gawain sa mga istrukturadong kapaligiran ng pabrika. Gayunpaman, ang kasalukuyang artificial intelligence (AI) ay lubusang binabago ang larangan ng robotika, na nagbibigay-daan sa mga robot na maunawaan at maisagawa ang mga utos ng gumagamit habang umaangkop sa pabago-bagong kapaligiran.

Pumapasok tayo sa isang mabilis na lumalagong bagong panahon. Ayon sa Citibank, inaasahang aabot sa 1.3 bilyong robot ang ide-deploy sa buong mundo pagsapit ng 2035, at ang saklaw ng aplikasyon nito ay lalawak mula sa mga pabrika patungo sa mga tahanan at industriya ng serbisyo. Samantala, tinatayang ng Morgan Stanley na ang merkado ng humanoid robot lamang ay maaaring umabot sa $5 trilyon pagsapit ng 2050.

Bagama't ang paglawak na ito ay naglalabas ng napakalaking potensyal sa merkado, kaakibat nito ang malalaking hamon sa sentralisasyon, tiwala, privacy, at scalability. Sa kabilang banda, ang teknolohiya ng Web3 ay nag-aalok ng mga makabagong solusyon sa pamamagitan ng pagsuporta sa desentralisado, nabeberipika, protektado ang privacy, at kolaboratibong robot network upang matugunan ang mga isyung ito.

Sa artikulong ito, susuriin natin nang malalim ang patuloy na umuunlad na value chain ng AI robot, partikular na tututok sa larangan ng humanoid robot, at ilalahad ang mga kapana-panabik na oportunidad na dulot ng pagsasanib ng AI robot at teknolohiya ng Web3.

Value Chain ng AI Robot

Ang value chain ng AI robot ay binubuo ng apat na pangunahing antas: hardware, intelligence, data, at agent. Ang bawat antas ay nakasalalay sa iba pa, na nagbibigay-daan sa mga robot na makaramdam, mag-reason, at kumilos sa masalimuot na totoong mundo.

Sa mga nakaraang taon, sa pamumuno ng mga industry pioneer gaya ng Unitree at Figure AI, ang hardware layer ay nakamit ang makabuluhang pag-unlad. Gayunpaman, marami pa ring mahahalagang hamon sa non-hardware layers, partikular na ang kakulangan ng mataas na kalidad na dataset, kakulangan ng general-purpose foundation model, mahinang compatibility sa iba't ibang device, at pangangailangan para sa maaasahang edge computing. Kaya naman, ang pinakamalaking oportunidad sa kasalukuyan ay nasa intelligence layer, data layer, at agent layer.

1.1 Hardware Layer: “Katawan”

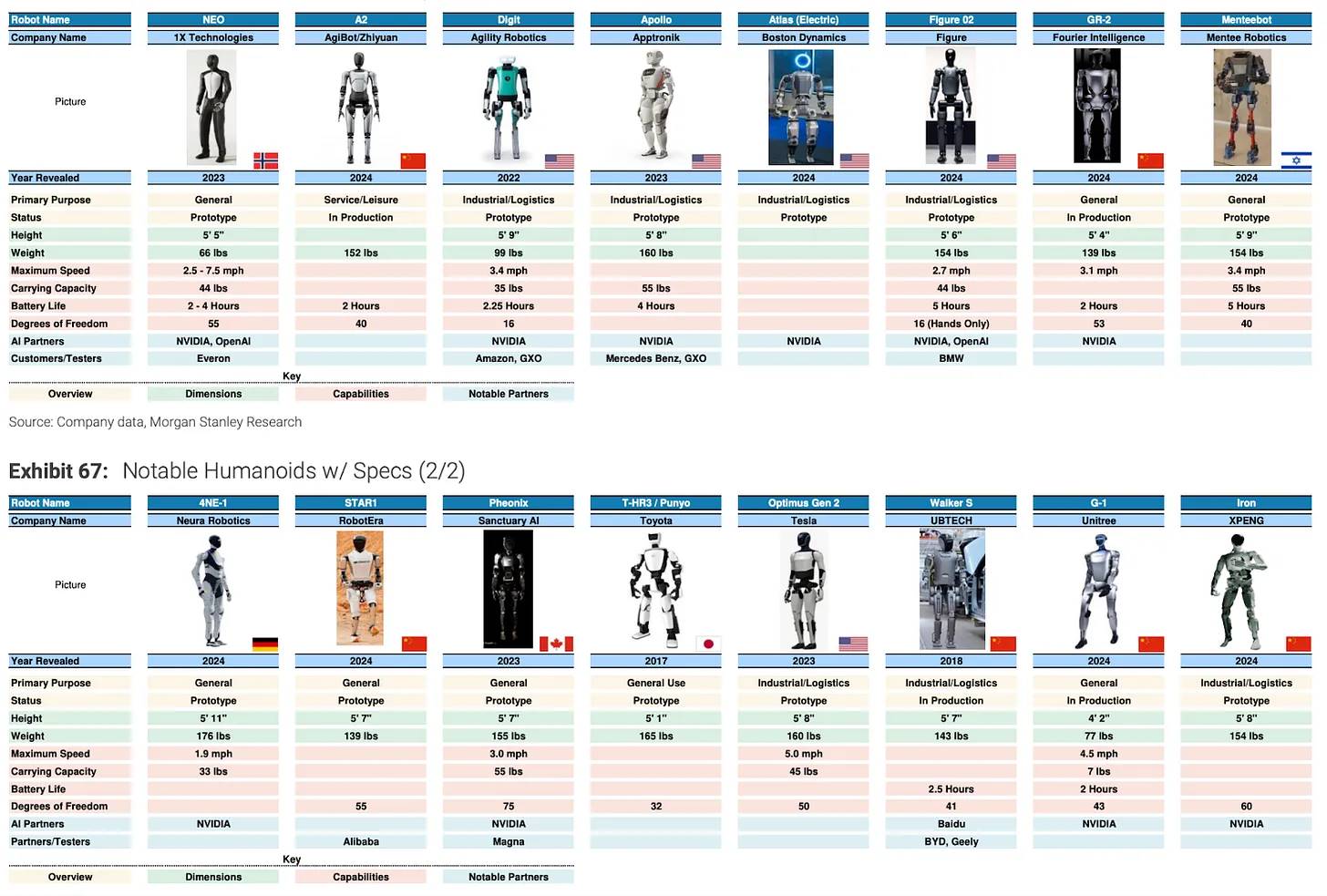

Sa kasalukuyan, mas madali nang gumawa at mag-deploy ng modernong “katawan ng robot” kaysa dati. Mayroon nang mahigit 100 iba't ibang uri ng humanoid robot sa merkado, kabilang ang Optimus ng Tesla, G1 ng Unitree, Digit ng Agility Robotics, at Figure 02 ng Figure AI.

Pinagmulan: Morgan Stanley, “Humanoid Robots 100: Humanoid Robot Value Chain Map”

Ang pag-unlad na ito ay bunga ng mga teknolohikal na tagumpay sa tatlong pangunahing bahagi:

-

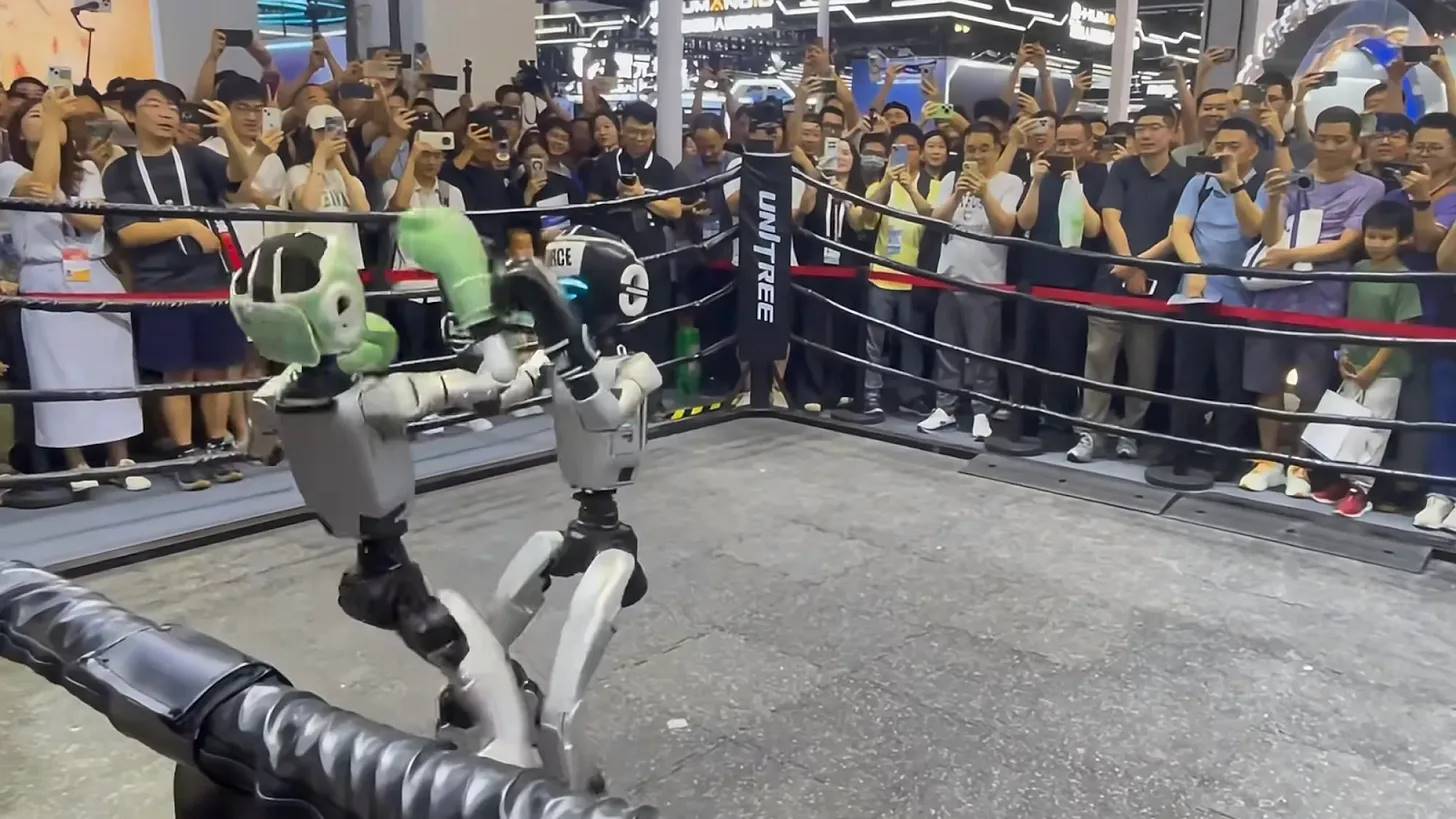

Actuators: Bilang “mga kalamnan” ng robot, ang actuators ay nagko-convert ng digital na utos sa eksaktong galaw. Ang inobasyon sa high-performance motors ay nagbibigay-daan sa mga robot na magsagawa ng mabilis at eksaktong kilos, habang ang dielectric elastomer actuators (DEAs) ay angkop para sa mas pinong gawain. Malaki ang naitulong ng mga teknolohiyang ito sa flexibility ng robot, gaya ng Optimus Gen 2 ng Tesla na may 22 degrees of freedom (DoF), at G1 ng Unitree, na nagpapakita ng flexibility na halos katulad ng tao at kahanga-hangang kakayahan sa paggalaw.

Pinagmulan: Unitree na nagpapakita ng pinakabagong humanoid robot sa 2025 WAIC World Artificial Intelligence Conference na nakikipag-boxing

-

Sensors: Ang mga advanced na sensor ay nagbibigay-daan sa robot na maramdaman at maunawaan ang kapaligiran sa pamamagitan ng visual, LIDAR/RADAR, tactile, at audio input. Sinusuportahan ng mga teknolohiyang ito ang ligtas na pag-navigate, eksaktong operasyon, at contextual awareness ng robot.

-

Embedded Computing: Ang mga CPU, GPU, at AI accelerator (tulad ng TPU at NPU) sa device ay kayang magproseso ng sensor data at magpatakbo ng AI models nang real-time, na nagbibigay-daan sa autonomous na desisyon. Ang maaasahang low-latency na koneksyon ay nagsisiguro ng seamless na koordinasyon, habang ang hybrid edge-cloud architecture ay nagbibigay-daan sa robot na mag-offload ng intensive computing tasks kapag kinakailangan.

1.2 Intelligence Layer: “Utak”

Habang lalong nagiging mature ang hardware, ang pokus ng industriya ay lumilipat sa pagbuo ng “utak ng robot”: makapangyarihang foundation models at advanced na control strategies.

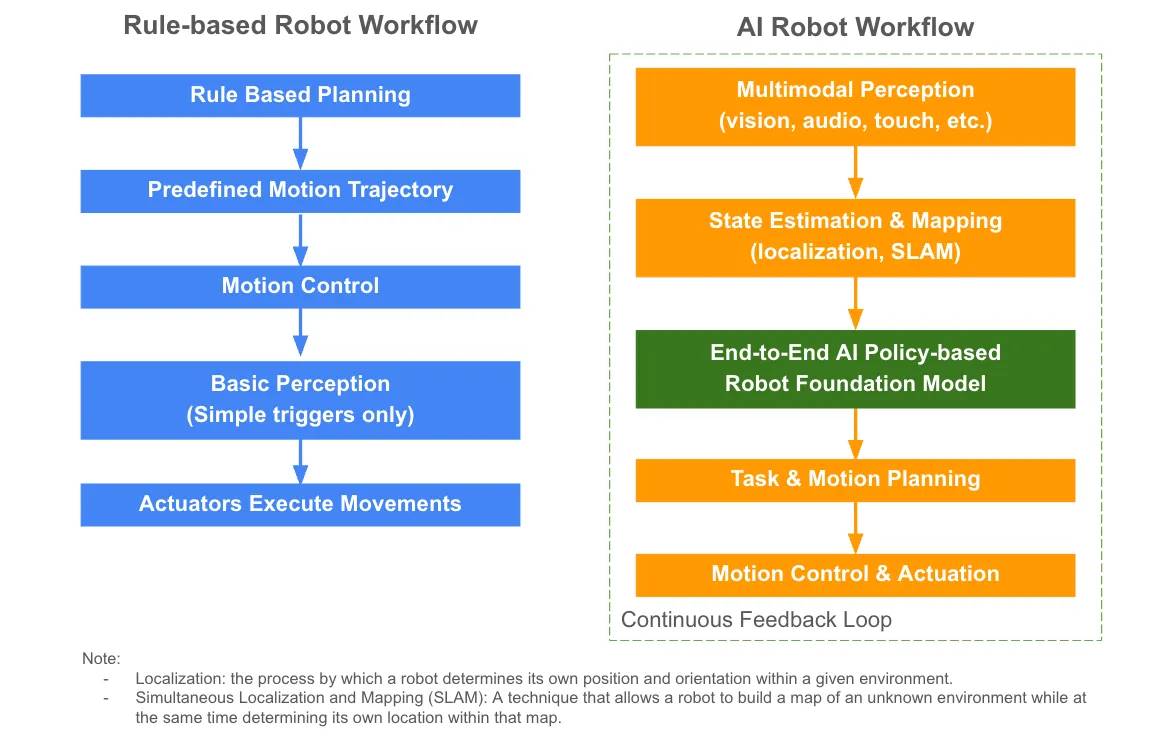

Bago ang integrasyon ng AI, ang mga robot ay umaasa sa rule-based automation, na gumagawa ng mga pre-programmed na kilos na kulang sa adaptive intelligence.

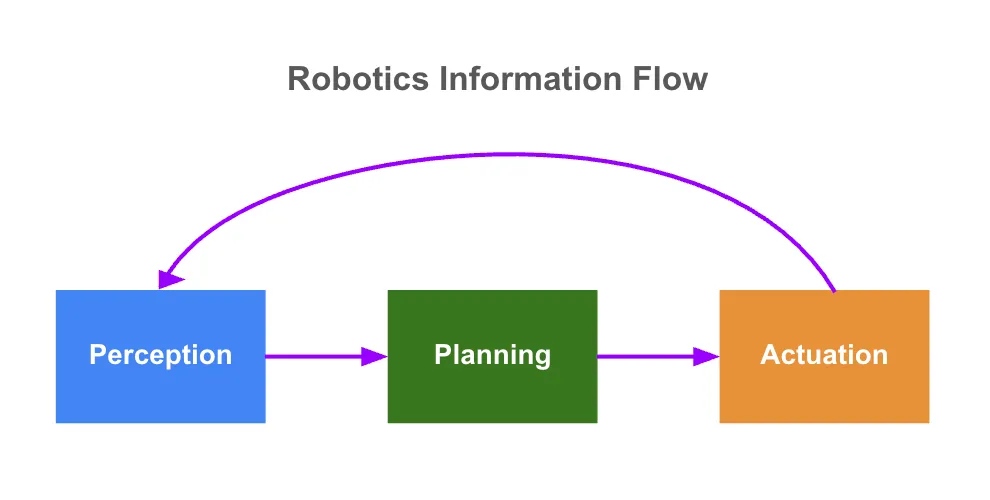

Unti-unti nang naiaangkop ang foundation models sa larangan ng robotika. Gayunpaman, hindi sapat ang generic large language models (LLMs) lamang, dahil kailangan ng mga robot na makaramdam, mag-reason, at kumilos sa dynamic na pisikal na mundo. Upang matugunan ang mga pangangailangang ito, ang industriya ay bumubuo ng policy-based end-to-end robot foundation models. Ang mga modelong ito ay nagbibigay-daan sa robot na:

-

Makaramdam (Perceive): Tumanggap ng multimodal sensor data (visual, audio, tactile)

-

Magplano (Plan): Tantiya ang sariling estado, gumuhit ng mapa ng kapaligiran, at mag-interpret ng kumplikadong utos, direktang i-map ang perception sa action, at bawasan ang manual engineering intervention

-

Kumilos (Act): Bumuo ng motion plan at maglabas ng control command para sa real-time na execution

Ang mga modelong ito ay natututo ng general “policy” ng pakikipag-ugnayan sa mundo, na nagbibigay-daan sa robot na umangkop sa iba't ibang gawain at gumana nang may mas mataas na katalinuhan at awtonomiya. Gumagamit din ang mga advanced na modelo ng tuloy-tuloy na feedback upang matutunan ng robot mula sa karanasan, na higit pang nagpapahusay ng adaptability sa dynamic na kapaligiran.

Ang VLA model ay direktang nagma-map ng sensory input (pangunahing visual data at natural language instructions) sa kilos ng robot, na nagbibigay-daan sa robot na maglabas ng tamang control command batay sa “nakikita” at “naririnig” nito. Ilan sa mga kapansin-pansing halimbawa ay ang RT-2 ng Google, Isaac GR00T N1 ng Nvidia, at π0 ng Physical Intelligence.

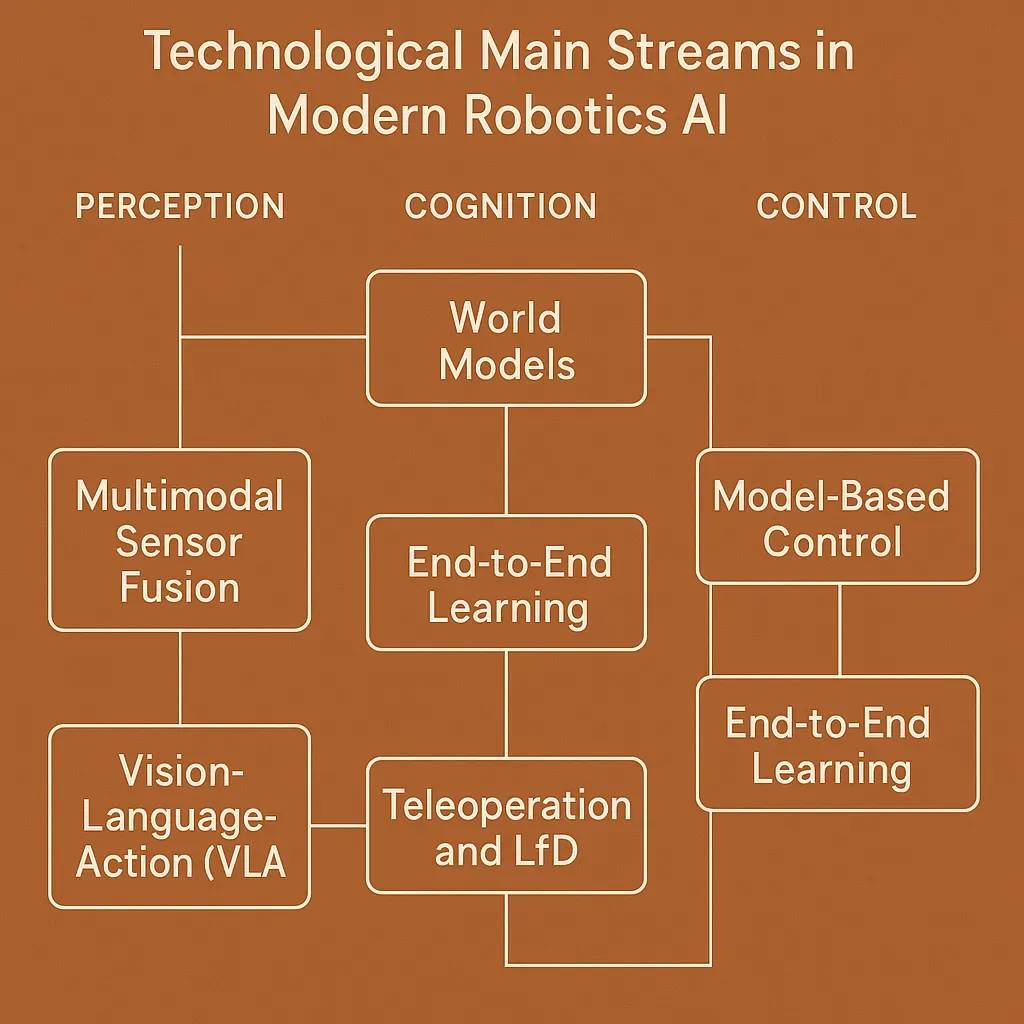

Upang mapahusay ang mga modelong ito, karaniwang pinagsasama ang iba't ibang complementary approaches, tulad ng:

-

World Models: Bumubuo ng internal simulation ng pisikal na kapaligiran upang matulungan ang robot na matutunan ang kumplikadong pag-uugali, mag-predict ng resulta, at magplano ng aksyon. Halimbawa, ang Genie 3 ng Google ay isang general-purpose world model na kayang bumuo ng hindi pa nakikitang iba't ibang interactive environment.

-

Deep Reinforcement Learning: Tinutulungan ang robot na matutunan ang pag-uugali sa pamamagitan ng trial and error.

-

Teleoperation: Nagbibigay-daan sa remote control at pagbibigay ng training data.

-

Learning from Demonstration (LfD)/Imitation Learning: Tinuturuan ang robot ng bagong kasanayan sa pamamagitan ng paggaya sa kilos ng tao.

Ipinapakita ng larawan sa ibaba kung paano gumagana ang mga pamamaraang ito sa robot foundation models.

Pinagmulan: World models: the physical intelligence core driving us toward AGI

Ilan sa mga pinakabagong open-source breakthroughs, gaya ng π0 ng Physical Intelligence at Isaac GR00T N1 ng Nvidia, ay nagmamarka ng mahalagang pag-unlad sa larangang ito. Gayunpaman, karamihan sa mga robot foundation models ay nananatiling sentralisado at closed-source. Ang mga kumpanya tulad ng Covariant at Tesla ay patuloy na nagtatago ng proprietary code at dataset, pangunahin dahil sa kakulangan ng open incentive mechanism.

Ang kakulangan ng transparency na ito ay nililimitahan ang kolaborasyon at interoperability sa pagitan ng mga robot platform, na nagpapatingkad sa pangangailangan para sa ligtas at transparent na model sharing, on-chain standards para sa community governance, at interoperability layer sa iba't ibang device. Ang ganitong pamamaraan ay magpapalakas ng tiwala, kooperasyon, at magtutulak ng mas malakas na pag-unlad sa larangang ito.

1.3 Data Layer: “Kaalaman” ng Utak

Ang malalakas na robot dataset ay nakasalalay sa tatlong haligi: dami, kalidad, at diversity.

Bagama't may mga pagsisikap na gawin sa data accumulation, ang kasalukuyang laki ng robot dataset ay malayo pa rin sa sapat. Halimbawa, ang GPT-3 ng OpenAI ay sinanay sa 300 bilyong token, habang ang pinakamalaking open-source robot dataset na Open X-Embodiment ay naglalaman lamang ng mahigit 1 milyong totoong robot trajectory, na sumasaklaw sa 22 uri ng robot. Malayo ito sa kinakailangang scale ng data upang makamit ang malakas na generalization ability.

Ilang proprietary methods, gaya ng pangongolekta ng data ng Tesla sa pamamagitan ng data factory kung saan ang mga manggagawa ay nagsusuot ng motion capture suit upang bumuo ng training data, ay nakakatulong ngang makalikom ng mas maraming totoong motion data. Gayunpaman, mahal ang mga pamamaraang ito, limitado ang diversity ng data, at mahirap i-scale.

Upang matugunan ang mga hamong ito, ginagamit ng larangan ng robotika ang sumusunod na tatlong pangunahing pinagmumulan ng data:

-

Internet Data: Malaki at madaling i-scale ang internet data, ngunit pangunahing observational data ito na kulang sa sensor at motion signals. Sa pamamagitan ng pre-training ng malalaking visual language models (tulad ng GPT-4V at Gemini) sa internet data, maaaring makuha ang mahalagang semantic at visual priors. Bukod dito, ang pagdaragdag ng kinematic labels sa video ay nagko-convert ng raw video sa actionable training data.

-

Synthetic Data: Ang synthetic data na nabubuo sa simulation ay nagbibigay-daan sa mabilis na malakihang eksperimento at sumasaklaw sa iba't ibang scenario, ngunit hindi nito ganap na naipapakita ang complexity ng totoong mundo—isang limitasyon na tinatawag na “sim-to-real gap.” Nilulutas ito ng mga researcher sa pamamagitan ng domain adaptation (tulad ng data augmentation, domain randomization, adversarial learning) at sim-to-real transfer, na iterative na ino-optimize ang model at sinusubok/finetune ito sa totoong kapaligiran.

-

Totoong World Data: Bagama't bihira at mahal, ang totoong world data ay mahalaga para sa deployment ng model at pag-bridge ng gap sa pagitan ng simulation at aktwal na paggamit. Karaniwang may mataas na kalidad ang totoong data, kabilang ang egocentric views na nagre-record ng “nakikita” ng robot sa task, at motion data na nagtatala ng eksaktong kilos nito. Karaniwang kinokolekta ang motion data sa pamamagitan ng human demonstration o teleoperation gamit ang VR, motion capture device, o tactile teaching, upang matiyak na natututo ang model mula sa tumpak na totoong halimbawa.

Ipinapakita ng mga pag-aaral na ang pagsasanib ng internet data, totoong world data, at synthetic data sa robot training ay mas nakakapagpabilis ng training efficiency at robustness ng model kumpara sa paggamit ng alinmang pinagmumulan lamang (Deep Tide note: robustness ay tumutukoy sa kakayahan ng system na manatiling matatag at malakas sa harap ng abnormal o mapanganib na sitwasyon).

Samantala, bagama't nakakatulong ang pagdagdag ng dami ng data, mas mahalaga ang diversity ng data, lalo na para sa generalization sa mga bagong gawain at robot morphology. Upang makamit ang diversity na ito, kinakailangan ang open data platforms at collaborative data sharing, kabilang ang paglikha ng cross-instance datasets na sumusuporta sa iba't ibang robot morphology, na nagtutulak ng mas malakas na foundation models.

1.4 Agent Layer: “Physical AI Agent”

Ang trend ng pag-unlad patungo sa physical AI agents ay bumibilis, kung saan ang mga autonomous robot ay kayang kumilos nang mag-isa sa totoong mundo. Ang pag-unlad sa agent layer ay nakasalalay sa fine-tuning ng model, tuloy-tuloy na pagkatuto, at aktwal na pag-aangkop sa natatanging morphology ng bawat robot.

Narito ang ilang umuusbong na oportunidad upang pabilisin ang pag-unlad ng physical AI agents:

-

Continuous Learning at Adaptive Infrastructure: Sa pamamagitan ng real-time feedback loop at shared experiences sa panahon ng deployment, patuloy na napapabuti ng mga robot ang sarili.

-

Autonomous Agent Economy: Ang mga robot ay gumagana bilang independent economic entities—nakikipagpalitan ng resources gaya ng computing power at sensor data sa robot-to-robot market, at kumikita sa pamamagitan ng tokenized services.

-

Multi-agent Systems: Ang susunod na henerasyon ng mga platform at algorithm ay nagbibigay-daan sa mga grupo ng robot na mag-coordinate, mag-collaborate, at mag-optimize ng collective behavior.

Pagsasanib ng AI Robot at Web3: Pagpapalaya ng Napakalaking Potensyal ng Merkado

Habang ang AI robot ay lumilipat mula sa research phase patungo sa aktwal na deployment sa totoong mundo, maraming matagal nang bottleneck ang pumipigil sa inobasyon at nililimitahan ang scalability, robustness, at economic viability ng robot ecosystem. Kabilang dito ang sentralisadong data at model islands, kakulangan ng tiwala at traceability, privacy at compliance restrictions, at kakulangan ng interoperability.

2.1 Mga Sakit na Hinaharap ng AI Robot

-

Sentralisadong Data at Model Islands

Kailangan ng robot models ng malaki at diverse na dataset. Gayunpaman, ang kasalukuyang data at model development ay highly centralized, fragmented, at magastos, na nagreresulta sa mga system na hiwa-hiwalay at mahina ang adaptability. Sa deployment ng robot sa dynamic na totoong mundo, madalas na hindi maganda ang performance dahil sa kakulangan ng data diversity at robustness ng model.

-

Tiwala, Traceability, at Reliability

Ang kakulangan ng transparent at auditable records (kabilang ang data provenance, proseso ng model training, at robot operation history) ay nagpapahina ng tiwala at pananagutan. Ito ang pangunahing hadlang sa pag-adopt ng mga robot ng mga user, regulator, at negosyo.

-

Privacy, Security, at Compliance

Sa mga sensitibong aplikasyon gaya ng medical at home robots, napakahalaga ng privacy protection at kailangang sumunod sa mahigpit na regional regulations (tulad ng General Data Protection Regulation (GDPR) ng Europe). Nahihirapan ang centralized infrastructure na suportahan ang secure at privacy-preserving AI collaboration, na nililimitahan ang data sharing at pinipigilan ang inobasyon sa regulated o sensitibong larangan.

-

Scalability at Interoperability

Ang mga robot system ay nahaharap sa malalaking hamon sa resource sharing, collaborative learning, at integration sa iba't ibang platform at morphology. Ang mga limitasyong ito ay nagdudulot ng fragmented network effects at pumipigil sa mabilis na transfer ng kakayahan sa pagitan ng iba't ibang uri ng robot.

2.2 AI Robot x Web3: Estruktural na Solusyon ang Nagtutulak ng Mga Oportunidad na Maaaring Pag-investan

Ang teknolohiya ng Web3 ay radikal na nilulutas ang mga nabanggit na sakit sa pamamagitan ng desentralisado, nabeberipika, protektado ang privacy, at kolaboratibong robot network. Ang pagsasanib na ito ay nagbubukas ng mga bagong oportunidad sa merkado para sa investment:

-

Desentralisadong Collaborative Development: Sa pamamagitan ng incentive-driven network, maaaring magbahagi ng data ang mga robot, mag-collaborate sa pag-develop ng models at intelligent agents.

-

Nabeberipikang Traceability at Accountability: Tinitiyak ng blockchain technology ang hindi nababago at nabeberipikang record ng data at model provenance, robot identity, at operation history—mahalaga para sa tiwala at compliance.

-

Privacy-preserving Collaboration: Pinapayagan ng advanced cryptographic solutions ang mga robot na mag-train ng models at magbahagi ng insights nang hindi isinusuko ang proprietary o sensitibong data.

-

Community-driven Governance: Ang decentralized autonomous organizations (DAOs) ay gumagabay at nag-o-oversee sa robot operations sa pamamagitan ng on-chain, transparent, at inclusive na mga patakaran.

-

Cross-morphology Interoperability: Ang open blockchain-based frameworks ay nagpapadali ng seamless collaboration sa pagitan ng iba't ibang robot platforms, nagpapababa ng development cost, at nagpapabilis ng capability transfer.

-

Autonomous Agent Economy: Ang Web3 infrastructure ay nagbibigay ng independent economic agent identity sa mga robot, na nagpapahintulot sa peer-to-peer transactions, negotiation, at paglahok sa tokenized markets nang walang human intervention.

-

Decentralized Physical Infrastructure Network (DePIN): Ang blockchain-based peer-to-peer sharing ng computing, sensing, storage, at connectivity resources ay nagpapalakas ng scalability at resilience ng robot network.

Narito ang ilang makabagong proyekto na nagtutulak ng pag-unlad sa larangang ito, na nagpapakita ng potensyal at trend ng pagsasanib ng AI robot at Web3. Siyempre, ito ay para sa sanggunian lamang at hindi investment advice.

Desentralisadong Data at Model Development

Ang mga Web3-driven platform ay nagde-demokratize ng data at model development sa pamamagitan ng pag-incentivize ng mga contributor (gaya ng motion capture suit, sensor sharing, visual upload, data annotation, at maging synthetic data generation). Ang pamamaraang ito ay nakabubuo ng mas mayaman, diverse, at representatibong dataset at models, na higit pa sa kayang gawin ng isang kumpanya. Pinapalakas din ng desentralisadong framework ang coverage ng edge cases, na mahalaga para sa mga robot na gumagana sa unpredictable na kapaligiran.

Mga Halimbawa:

-

Frodobots : Isang protocol para sa crowdsourcing ng real-world dataset sa pamamagitan ng robot games. Inilunsad nila ang “Earth Rovers” project—isang sidewalk robot at global “Drive to Earn” game, na matagumpay na nakabuo ng FrodoBots 2K Dataset na naglalaman ng camera footage, GPS data, audio recordings, at human control data, na sumasaklaw sa mahigit 10 lungsod at may kabuuang humigit-kumulang 2,000 oras ng remote robot driving data.

-

BitRobot : Isang crypto-incentivized platform na magkasamang binuo ng FrodoBots Lab at Protocol Labs, batay sa Solana blockchain at subnet architecture. Ang bawat subnet ay itinakda bilang public challenge, at ang mga contributor ay tumatanggap ng token rewards sa pamamagitan ng pagsusumite ng model o data, na nag-iincentivize ng global collaboration at open-source innovation.

-

Reborn Network : Ang foundational layer ng AGI robot open ecosystem, na nagbibigay ng Rebocap motion capture suit upang payagan ang sinuman na mag-record at kumita mula sa kanilang totoong motion data, na tumutulong sa pagbubukas ng complex humanoid robot dataset.

-

PrismaX : Gumagamit ng lakas ng global community contributors, tinitiyak ang data diversity at authenticity sa pamamagitan ng desentralisadong infrastructure, at nagpapatupad ng matibay na verification at incentive mechanism upang itulak ang scale ng robot dataset.

Patunay ng Traceability at Reliability

Ang blockchain technology ay nagbibigay ng end-to-end transparency at accountability sa robot ecosystem. Tinitiyak nito ang nabeberipikang traceability ng data at model, authentication ng robot identity at physical location, at malinaw na record ng operation history at participation ng contributor. Bukod dito, ang collaborative verification, on-chain reputation system, at stake-based validation mechanism ay nagsisiguro ng kalidad ng data at model, na pumipigil sa low-quality o fraudulent input na makasira sa ecosystem.

Mga Halimbawa:

-

OpenLedger : Isang AI blockchain infrastructure na gumagamit ng community-owned dataset para mag-train at mag-deploy ng dedicated models. Sa pamamagitan ng “Proof of Attribution” mechanism, tinitiyak nito na ang mga high-quality data contributor ay makakatanggap ng patas na gantimpala.

Tokenized Ownership, Licensing, at Monetization

Ang mga Web3-native intellectual property tools ay sumusuporta sa tokenized licensing ng dedicated dataset, robot capability, models, at intelligent agents. Maaaring gamitin ng mga contributor ang smart contract upang direktang i-embed ang licensing terms sa kanilang asset, na tinitiyak ang awtomatikong royalty payment kapag ni-reuse o na-monetize ang data o model. Pinapalakas ng pamamaraang ito ang transparent, permissionless access at lumilikha ng open at patas na merkado para sa robot data at models.

Mga Halimbawa:

-

Poseidon : Isang full-stack decentralized data layer na binuo batay sa IP-centric Story protocol, na nagbibigay ng legally authorized AI training data.

Privacy-preserving Solutions

Ang high-value data na nabubuo sa mga lugar tulad ng ospital, hotel room, o tahanan ay mahirap makuha sa pamamagitan ng public channels ngunit mayaman sa contextual information na makabuluhang nagpapahusay sa performance ng foundation models. Sa pamamagitan ng cryptographic solutions, maaaring gawing on-chain asset ang private data, na nagiging traceable, composable, at monetizable habang pinoprotektahan ang privacy. Ang mga teknolohiya gaya ng Trusted Execution Environments (TEEs) at Zero-Knowledge Proofs (ZKPs) ay sumusuporta sa secure computation at result verification nang hindi isinusuko ang raw data. Pinapayagan ng mga tool na ito ang mga organisasyon na mag-train ng AI models sa distributed sensitive data habang pinananatili ang privacy at compliance.

Mga Halimbawa:

-

Phala Network : Pinapayagan ang mga developer na mag-deploy ng application sa secure TEE para sa confidential AI at data processing.

Open at Auditable Governance

Karaniwang umaasa ang robot training sa proprietary black-box system na kulang sa transparency at adaptability. Napakahalaga ng transparent at nabeberipikang governance upang mabawasan ang risk at mapalakas ang tiwala ng user, regulator, at negosyo. Sa pamamagitan ng Web3 technology, naisasakatuparan ang collaborative development ng open-source robot intelligence sa ilalim ng on-chain, community-driven oversight.

Mga Halimbawa:

-

Openmind : Isang open AI-native software stack na tumutulong sa robot na mag-isip, matuto, at mag-collaborate. Iminungkahi nila ang ERC7777 standard upang magtatag ng nabeberipikang, rule-based robot ecosystem na nakatuon sa seguridad, transparency, at scalability. Tinutukoy ng standard na ito ang standardized interface para sa pamamahala ng human at robot identity, pagpapatupad ng social rule set, at registration at removal ng participant, na malinaw na naglalahad ng mga karapatan at responsibilidad.

Huling Pag-iisip

Habang nagsasanib ang AI robot at teknolohiya ng Web3, pumapasok tayo sa isang bagong panahon kung saan ang mga autonomous system ay kayang makipag-collaborate at umangkop sa malakihang antas. Ang susunod na 3 hanggang 5 taon ay magiging kritikal, kung saan ang mabilis na pag-unlad ng hardware ay magtutulak sa paglitaw ng mas malalakas na AI models na umaasa sa mas mayamang real-world dataset at desentralisadong collaborative mechanism. Inaasahan naming lilitaw ang mga dedicated AI agent sa mga industriya tulad ng hotel at logistics, na lilikha ng napakalaking bagong oportunidad sa merkado.

Gayunpaman, ang pagsasanib ng AI robot at cryptographic technology ay nagdadala rin ng mga hamon. Ang disenyo ng balanse at epektibong incentive mechanism ay nananatiling kumplikado at patuloy na umuunlad—kailangang patas na gantimpalaan ang mga contributor habang iniiwasan ang pang-aabuso. Ang teknikal na complexity ay isa ring malaking hamon, na nangangailangan ng pagbuo ng matatag at scalable na solusyon upang makamit ang seamless integration ng iba't ibang uri ng robot. Bukod dito, kailangang sapat na maaasahan ang privacy-preserving technology upang makuha ang tiwala ng mga stakeholder, lalo na sa paghawak ng sensitibong data. Ang mabilis na nagbabagong regulatory environment ay nangangailangan din ng maingat na pagharap upang matiyak ang compliance sa iba't ibang hurisdiksyon. Ang pagtugon sa mga risk na ito at pagkamit ng sustainable returns ay susi sa pagtutulak ng technological advancement at malawakang aplikasyon.

Sama-sama nating tutukan ang pag-unlad ng larangang ito, itaguyod ang progreso sa pamamagitan ng kolaborasyon, at samantalahin ang mga oportunidad na lumilitaw sa mabilis na lumalawak na merkado.

Ang inobasyon sa teknolohiya ng robotika ay isang paglalakbay na pinakamainam na tahakin nang magkakasama :)

Sa huli, nais kong pasalamatan ang Chain of Thought na ang “Robotics & The Age of Physical AI” ay nagbigay ng mahalagang suporta sa aking pananaliksik.