Inilunsad ng NVIDIA ang bagong henerasyon ng Rubin platform, 10 beses na mas mababa ang gastos sa inference kumpara sa Blackwell, at planong magpadala ng mga produkto sa ikalawang kalahati ng taon

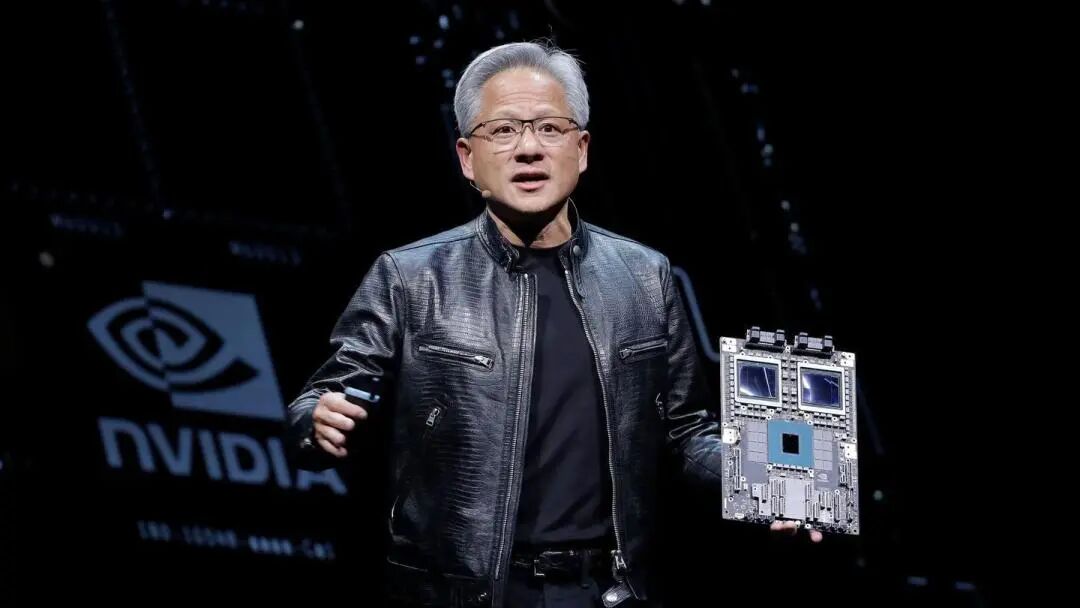

Inilunsad ng Nvidia ang bagong henerasyon ng Rubin AI platform sa CES, na nagpapakita ng patuloy na taunang pag-update ng kumpanya sa larangan ng artificial intelligence (AI) chips. Sa pamamagitan ng integrated design ng anim na bagong chips, ang platform na ito ay nagdulot ng malaking pagtaas sa inference cost at training efficiency, at inaasahang ihahatid ang unang batch ng mga customer sa ikalawang kalahati ng 2026.

Noong ika-5 ng Enero, Lunes, sa oras ng Silangang Baybayin ng Estados Unidos, sinabi ni Nvidia CEO Jensen Huang sa Las Vegas na ang anim na Rubin chips ay bumalik na mula sa mga kasosyong pabrika at nakapasa na sa ilan sa mga kritikal na pagsubok, at kasalukuyang sumusunod sa plano. Binanggit niya na "Nagsimula na ang AI race, at lahat ay nagsisikap maabot ang susunod na antas." Idiniin ng Nvidia na ang operating cost ng mga sistemang batay sa Rubin ay mas mababa kaysa sa Blackwell version, dahil maaari nitong makamit ang parehong resulta gamit ang mas kaunting mga bahagi.

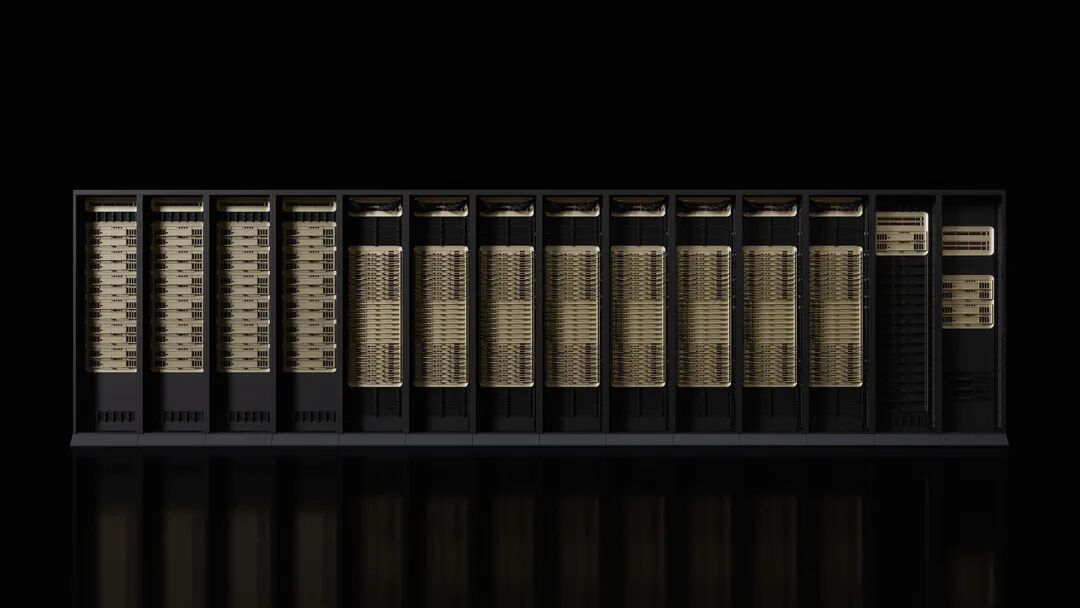

Ang Microsoft at iba pang malalaking cloud computing provider ang magiging unang batch ng mga customer na magde-deploy ng bagong hardware sa ikalawang kalahati ng taon. Ang susunod na henerasyon ng Fairwater AI superfactory ng Microsoft ay magkakaroon ng Nvidia Vera Rubin NVL72 rack-level system, na maaaring lumawak sa daan-daang libong Nvidia Vera Rubin superchips. Ang CoreWeave ay isa rin sa mga unang provider na mag-aalok ng Rubin system.

Ang paglulunsad ng platform na ito ay dumating habang may ilang alalahanin sa Wall Street tungkol sa tumitinding kumpetisyon na kinakaharap ng Nvidia, at pagdududa kung mananatili ang kasalukuyang bilis ng paggastos sa larangan ng AI. Gayunpaman, nananatiling matatag ang Nvidia sa kanilang pangmatagalang bullish forecast, na tinatayang ang total market size ay maaaring umabot sa trilyong dolyar.

Pagtaas ng Performance para sa Bagong Henerasyon ng Pangangailangan sa AI

Ayon sa anunsyo ng Nvidia, ang kakayahan sa training ng Rubin platform ay 3.5 beses na mas mataas kaysa Blackwell, at ang performance nito sa pagpapatakbo ng AI software ay 5 beses na mas mataas. Kumpara sa Blackwell platform, maaaring pababain ng Rubin hanggang 10 beses ang inference token generation cost, at nababawasan ng apat na beses ang bilang ng GPU na kailangan para magsanay ng mixture of experts (MoE) na modelo.

Ang bagong platform ay nilagyan ng Vera CPU na may 88 cores, na may performance na doble kaysa sa mga alternatibong produkto. Ang CPU na ito ay partikular na dinisenyo para sa inference delegation, at ito ang pinaka-energy efficient processor para sa malakihang AI factories, gamit ang 88 custom Olympus cores, full Armv9.2 compatibility, at napakabilis na NVLink-C2C connection.

Ang Rubin GPU ay may kasamang third-generation Transformer engine, na may hardware-accelerated adaptive compression, at kayang magbigay ng 50 petaflops ng NVFP4 computing power para sa AI inference. Bawat GPU ay nag-aalok ng 3.6TB/s bandwidth, habang ang Vera Rubin NVL72 rack ay nagbibigay ng 260TB/s bandwidth.

Maayos ang Progreso ng Chip Testing

Ibinunyag ni Jensen Huang na lahat ng anim na Rubin chips ay bumalik na mula sa manufacturing partners at nakapasa na sa mahahalagang pagsusuri na nagpapakita ng kanilang kakayahang i-deploy ayon sa plano. Pinatutunayan nito na napapanatili ng Nvidia ang kanilang leading position bilang AI accelerator manufacturer.

Ang platform ay naglalaman ng limang pangunahing teknolohikal na inobasyon: Ika-anim na henerasyon ng NVLink interconnect technology, Transformer engine, confidential computing, RAS engine, at Vera CPU. Sa mga ito, ang third-generation confidential computing technology ang ginagawang Vera Rubin NVL72 ang kauna-unahang rack-level platform na nagbibigay ng data security protection sa CPU, GPU, at NVLink domains.

Ang second-generation RAS engine ay sumasaklaw sa GPU, CPU, at NVLink, at may real-time health check, fault tolerance, at proactive maintenance features upang mapalaki ang productivity ng system. Ang rack ay gumagamit ng modular, cable-free tray design, na 18 beses na mas mabilis ang assembly at maintenance kaysa sa Blackwell.

Malawak na Suporta mula sa Ecosystem

Ayon sa Nvidia, kabilang ang AWS ng Amazon, Google Cloud, Microsoft, at Oracle Cloud ay unang magpapasimula ng deployment ng mga instance batay sa Vera Rubin sa 2026, at ang mga cloud partner na CoreWeave, Lambda, Nebius, at Nscale ay susunod din.

Pahayag ni OpenAI CEO Sam Altman: "Lumalakas ang intelligence kasabay ng pagdami ng compute. Kapag nadagdagan natin ang compute, nagiging mas malakas ang mga modelo, mas maraming problema ang nalulutas, at mas malaki ang epekto para sa mga tao. Ang Nvidia Rubin platform ay tumutulong sa amin na patuloy na palawigin ang pag-unlad na ito."

Sinabi ni Dario Amodei, co-founder at CEO ng Anthropic, na ang "pagtaas ng efficiency ng Rubin platform ng Nvidia ay kumakatawan sa infrastructure advancement na magbibigay-daan sa mas mahabang memory, mas mahusay na inference, at mas maaasahang output."

Ipinahayag ni Meta CEO Mark Zuckerberg na "ang Rubin platform ng Nvidia ay inaasahang magdadala ng step-change sa performance at efficiency, na kinakailangan upang ma-deploy ang pinaka-advanced na mga modelo sa bilyun-bilyong tao."

Dagdag pa ng Nvidia, sina Cisco, Dell, Hewlett Packard Enterprise, Lenovo, at Supermicro ay inaasahang maglulunsad ng iba't ibang server batay sa Rubin products. Ang mga AI laboratories tulad ng Anthropic, Cohere, Meta, Mistral AI, OpenAI, at xAI ay sabik na gamitin ang Rubin platform para magsanay ng mas malalaki at mas malalakas na modelo.

Maagang Pag-aanunsyo ng Detalye ng Produkto

Ayon sa mga komento, mas maaga ngayong taon kaysa dati inianunsyo ng Nvidia ang detalye ng bagong produkto, bilang hakbang upang mapanatili ang industriya na umaasa sa kanilang hardware. Karaniwan, mas detalyadong ipinapakilala ng Nvidia ang mga produkto nito sa GTC event sa San Jose, California tuwing tagsibol.

Para kay Jensen Huang, ang CES ay isa lamang sa maraming marathon na events na kanyang dadaluhan. Sa bawat event, mag-aanunsyo siya ng mga produkto, pakikipagtulungan, at pamumuhunan, lahat ay layuning mapalakas ang deployment ng AI system.

Kabilang sa mga bagong hardware na inanunsyo ng Nvidia ay mga network at connectivity components, na magiging bahagi ng DGX SuperPod supercomputer, at maaari ring gamitin bilang standalone na produkto para sa mas modular na paggamit ng mga customer. Ang pagtaas ng performance na ito ay kinakailangan, dahil ang AI ay lumilipat na sa mas specialized na model networks, hindi lamang upang salain ang napakalaking input, kundi upang lutasin din ang mga partikular na problema sa pamamagitan ng multi-stage na proseso.

Pinapalawak ng Nvidia ang aplikasyon ng AI sa buong larangan ng ekonomiya, kabilang ang robotics, healthcare, at heavy industry. Bilang bahagi ng pagsusumikap na ito, inanunsyo ng Nvidia ang isang serye ng mga tool upang pabilisin ang pagbuo ng mga autonomous na sasakyan at robot. Sa kasalukuyan, ang karamihan sa gastos sa computer na batay sa Nvidia ay mula sa capital expenditure budget ng ilang piling customer, kabilang ang Microsoft, Google Cloud ng Alphabet, at AWS ng Amazon.

Disclaimer: Ang nilalaman ng artikulong ito ay sumasalamin lamang sa opinyon ng author at hindi kumakatawan sa platform sa anumang kapasidad. Ang artikulong ito ay hindi nilayon na magsilbi bilang isang sanggunian para sa paggawa ng mga desisyon sa investment.

Baka magustuhan mo rin

Kung saan nabigo ang mga ambisyon ng Meta para sa metaverse

Ang pagtutok sa $900B na remittances ay maaaring magtulak sa Pinakamahusay na Crypto na Bilhin sa 2026

Huminto ang ETH at Bumaba ang Pepe, Ang Stage 2 Coin Burns ng Zero Knowledge Proof ay Maaaring Simula ng 7000x na Pagsabog!